Privacy e AI, il punto di Cisco sulla consapevolezza e il ruolo dell'Italia

Privacy, AI e cybersecurity: la percezione delle AI da parte degli utenti italiani e globali e le soluzioni innovative per proteggere i dati nella presentazione del Cisco Consumer Privacy Survey 2024.

La privacy dei consumatori e il ruolo dell’AI nella gestione dei dati sono sempre più al centro dell’attenzione globale. Per questo motivo è interessante l’approfondimento proposto in un evento stampa meneghino da Fabio Florio, BDM & Innovation Center Leader di Cisco, in relazione al recente Cisco Consumer Privacy Survey 2024 che da sei anni analizza le percezioni e i comportamenti dei cittadini di 12 paesi, tra cui Francia, Germania, Italia, Spagna, Regno Unito, Australia, Cina, India, Giappone, Brasile, Messico e Stati Uniti. Il report, pubblicato il 30 ottobre 2024, esplora sia il livello di consapevolezza rispetto alla privacy sia come le persone reagiscono all’integrazione dell’AI nella loro vita quotidiana.

I dati italiani

Un primo dato significativo riguarda la consapevolezza delle leggi sulla privacy: per la prima volta dall’esistenza del report, più della metà degli intervistati a livello globale (53%) dichiara di conoscere almeno in parte queste normative, seguendo un trend in costante aumento dal 2019. In questo frangente l’Italia si distingue positivamente con il 62%, al di sopra della media globale.

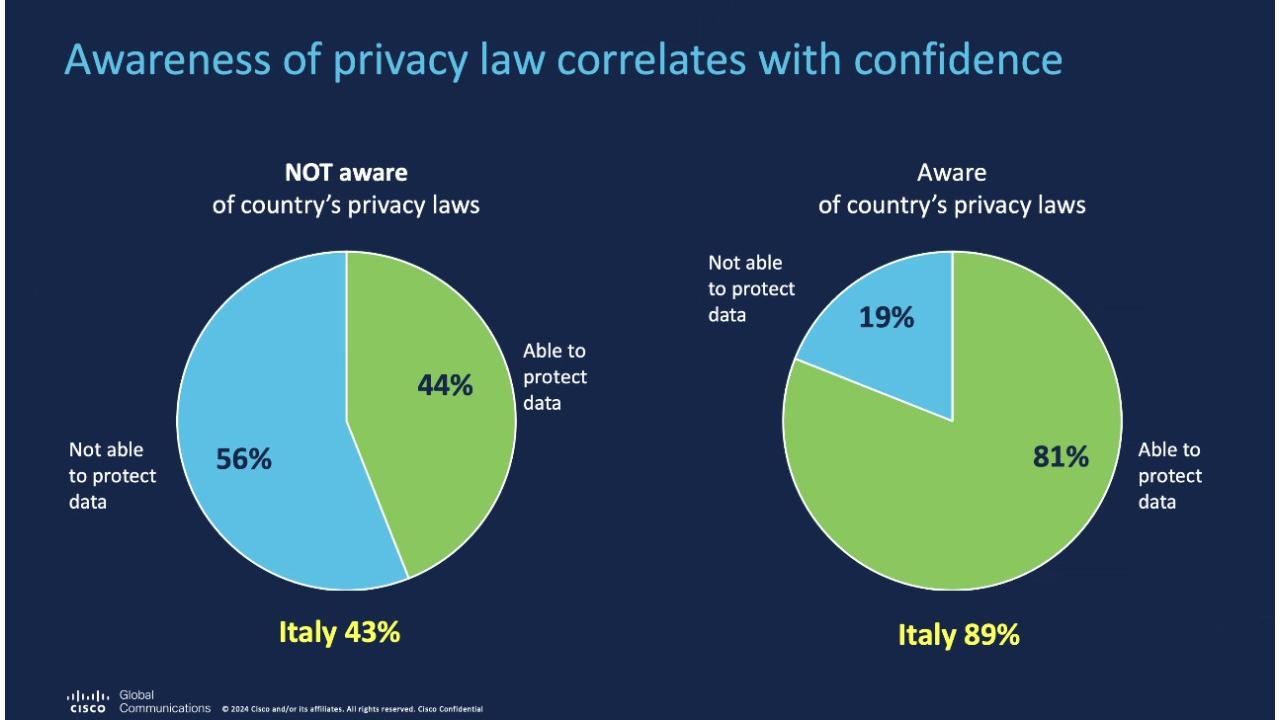

La correlazione tra consapevolezza e capacità di gestione dei dati è evidente: a livello globale, solo il 44% di chi non conosce le leggi sulla privacy si sente in grado di gestire i propri dati, contro l’81% di chi ne è consapevole. In Italia, questa differenza è ancora più marcata: l’89% degli italiani che ritengono di conoscere le normative si considera capace di proteggere le proprie informazioni, mentre tra chi ne è all’oscuro solo il 43% ritiene di avere tale capacità.

Gli italiani sembrano anche più attivi nel proteggere i propri dati personali rispetto alla media globale. Il 71% dichiara di aggiornare regolarmente le impostazioni sulla privacy, contro il 67% degli intervistati a livello globale. Inoltre, il 73% degli italiani dichiara di usare sistemi di autenticazione a più fattori e il 69% si avvale di password manager: strumenti essenziali per contrastare i furti di credenziali, a cui fa capo circa l’80% delle minacce informatiche globali.

Le differenze generazionali giocano un ruolo importante. I giovani tra i 18 e i 24 anni sono i più attivi nel modificare le impostazioni sulla privacy (51%), mentre nelle fasce d’età più avanzate, come gli over 75, questa percentuale scende drasticamente all’8%. Il divario evidenzia il ruolo chiave dell’alfabetizzazione digitale nella capacità di gestire la privacy personale.

Il 70% dei consumatori globali ritiene che le leggi sulla privacy abbiano un impatto positivo nel proprio paese. In Italia questa percentuale è leggermente inferiore (66%), ma i connazionali, al pari dei cittadini di altri paesi europei, auspicano un’armonizzazione delle normative a livello globale. Un’esigenza è particolarmente sentita in Europa, dove la coerenza tra le leggi è percepita come un fattore fondamentale per una protezione uniforme.

L’AI tra utilità e sfide

La seconda parte dell’indagine verte sull’intelligenza artificiale e sulle sue implicazioni etiche e pratiche. Il 68% degli italiani considera l’AI un elemento utile per migliorare la qualità della vita, superando in ottimismo il sentiment globale, che è del 63%. L’entusiasmo è bilanciato dalla richiesta di un utilizzo etico dell’AI: il 77% degli italiani (in linea con il 78% mondiale), ritiene che le aziende abbiano una responsabilità chiara nel garantire un uso trasparente e rispettoso di questa tecnologia.

In ambito AI è impossibile trascurare la crescente popolarità delle AI generative, che sono ormai usate abitualmente dal 23% dei consumatori globali (in aumento rispetto al 12% del 2023). Il dato italiano è simile: 22%, anche se gli intervistati esprimono preoccupazione per l’affidabilità dei risultati, la protezione dei dati personali e il rischio di bias.

A livello globale, i consumatori più entusiasti dell’AI sono quelli cinesi, con il 72% che la considera utile, mentre in Giappone questa percentuale scende al 54%. Circoscrivendo il dato all’AI generativa, gli Stati Uniti si distinguono con il 27% di utilizzo regolare superando la media globale, mentre in Spagna e Messico i dati sono rispettivamente del 21% e 19%.

AI e cybersecurity: una relazione stretta

Renzo Ghizzoni, Country Leader Cybersecurity Sales di Cisco Italia ha imperniato il proprio intervenuto sulle opzioni per aumentare il livello di sicurezza sfruttando l'intelligenza artificiale. Ghizzoni ha rassicurato circa il fatto che il vendor è “fortemente impegnato nel rendere sicuro l’utilizzo dell’intelligenza artificiale, ma anche nell’impiegarla per incrementare il livello di sicurezza”, motivo per il quale Cisco ha avviato un piano ambizioso per la formazione di circa 25 milioni di persone entro il 2032.

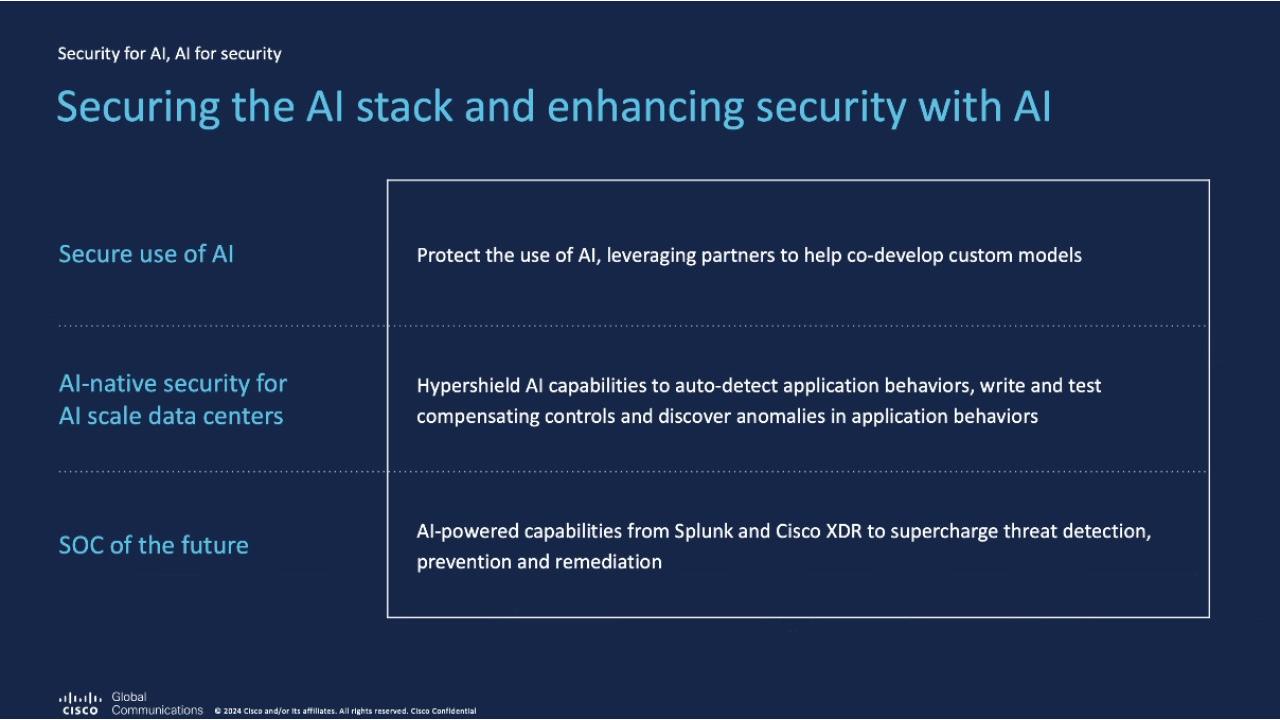

Nella visione di Cisco, mettere al sicuro l’AI comporta tre macro aree di intervento: proteggere le modalità con cui viene impiegata, introdurre soluzioni di sicurezza native pensate per proteggere i data center di nuova generazione e sfruttare l’AI per potenziare le capacità dei SOC, in modo da abilitare una maggiore cybersecurity.

Ghizzoni cita a titolo di esempio dell’impegno di Cisco la recente acquisizione di Robust Intelligence, che permette di offrire una soluzione che opera attraverso modelli e controlli sul ciclo di vita dei dati, garantendo che il dataset utilizzato per addestrare l’intelligenza artificiale sia protetto e privo di contaminazioni. Testimone dell’impegno per la protezione dei data center è invece HyperShield, descritta da Ghizzoni come “la più recente soluzione AI-native per la protezione dei data center, che integra comandi di sicurezza a livello nativo nei server, ed è già compatibile con ambienti cloud. HyperShield consente di rilevare e bloccare automaticamente minacce come l’exploit di vulnerabilità o traffico malevolo, agendo senza intervento umano grazie ai modelli di machine learning”.

Sul fronte del rafforzamento dei SOC, infine, Ghizzoni rimarca come oggi, grazie agli assistenti basati su AI, sia possibile supportare gli analisti in tempo reale, migliorando la loro capacità di identificare e rispondere alle minacce. “Inoltre – conclude Ghizzoni - l’uso di modelli di intelligenza artificiale ‘human-like’ permette di rendere i risultati dell’analisi comprensibili anche a livello umano, migliorando la velocità e l’efficacia della risposta agli incidenti.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

APT russo sfrutta un bug Office per spiare l’Europa

10-02-2026

SentinelOne estende la sicurezza AI con nuove funzioni DSPM

10-02-2026

AI agentica e cybersecurity: la lezione di OpenClaw

10-02-2026

Safer Internet Day 2026, identità digitale sotto attacco

10-02-2026

Redazione SecurityOpenLab

Redazione SecurityOpenLab