Nuove minacce GenAI: classificazione, impatti e difese efficaci

Le minacce GenAI evolvono: una guida tecnica alle categorie di attacco, ai rischi per le aziende e alle strategie di difesa più innovative.

La GenAI non è una tecnologia da temere, ma da proteggere. Come dimostrano precedenti analisi su Deceptive Delight e tecniche di Jailbreaking-to-Jailbreak, la battaglia si gioca sul piano dell'innovazione difensiva. Proseguendo con l’attività tecnico-divulgativa sulle minacce all’AI, gli esperti della Unit42 di Palo Alto Networks hanno pubblicato il report Securing GenAI: A Comprehensive Report on Prompt Attacks – Taxonomy, Risks and Solutions che esamina tutti gli attacchi emergenti alle applicazioni e agli agenti di AI, li classifica, ne dettaglia le percentuali di successo.

Inoltre, introduce una tassonomia completa sull’impatto di tali eventi, mappa le tecniche esistenti e spiega le contromisure da attuare con l’AI – perché sia chiaro: con l'aumentare delle sfide per la sicurezza dell'AI, è fondamentale difendere l'AI con l'AI. Si tratta in pratica di un framework vero e proprio, fatto per aiutare le imprese a comprendere, classificare e mitigare i rischi in modo efficace.

Un po’ di background

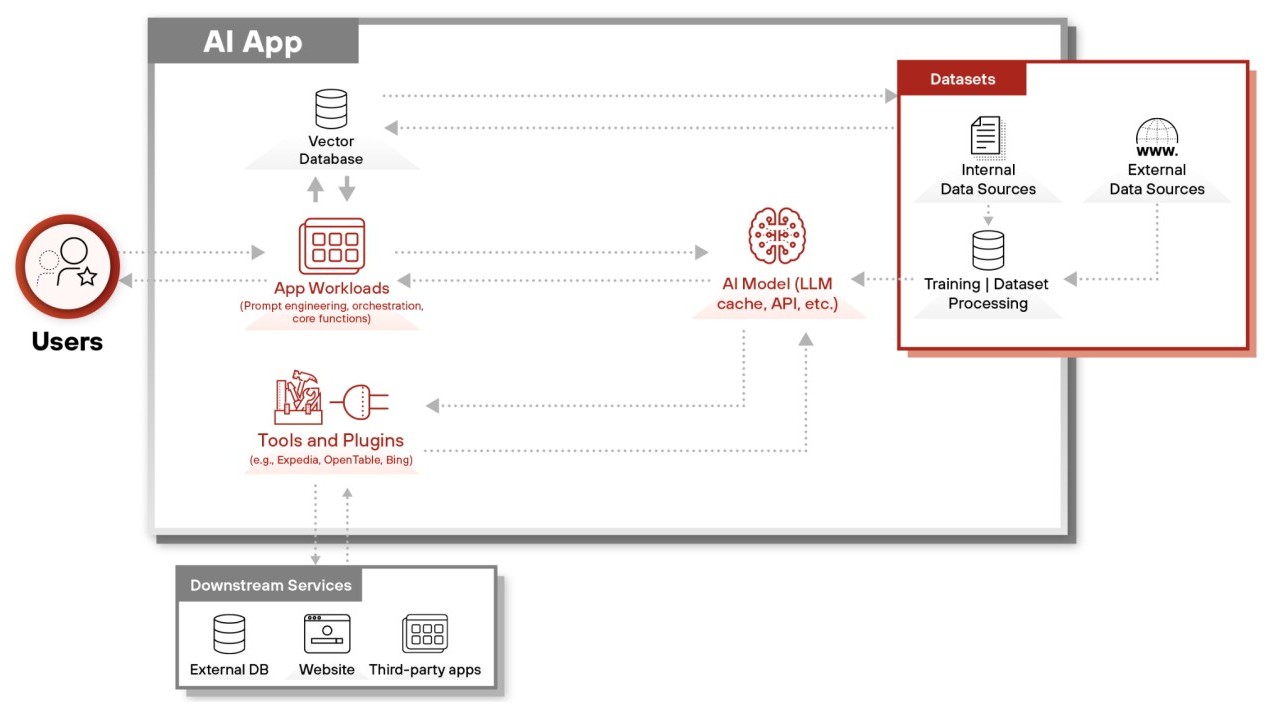

Per comprendere appieno la superficie di attacco offerta dai sistemi GenAI è fondamentale conoscerne l’architettura. Molto schematicamente, un’applicazione enterprise basata su GenAI integra una serie di elementi interdipendenti: i carichi di lavoro applicativi (che includono le interfacce utente, le strategie di prompt engineering e la logica di business); il modello AI vero e proprio, che può essere un foundation model, un modello fine-tuned o una soluzione ibrida. Il terzo elemento riguarda il dataset, che comprende sia le fonti utilizzate per il Retrieval-Augmented Generation (RAG) sia i dati di training. Infine, il quarto elemento è rappresentato dai tool e dai plugin, ovvero le API e i servizi esterni che vengono richiamati per l’esecuzione di task specifici. Ultimo elemento essenziale sono gli utenti finali o altre applicazioni che forniscono istruzioni. A complicare ulteriormente il quadro ci sono poi gli agenti AI, che aggiungono funzionalità di ragionamento autonomo, memoria a lungo termine e integrazione con strumenti esterni.

Questa architettura multilivello dà origine a molteplici superfici di attacco, fra cui per esempio la corruzione della memoria degli agenti (memory corruption) e lo sfruttamento malevolo di tool tramite tecniche come la SQL injection. Data la complessità delle interazioni tra questi componenti, il rilevamento delle minacce deve includere il monitoraggio degli input e degli output, le interazioni RAG e le integrazioni di strumenti.

Architettura di una tipica applicazione di intelligenza artificiale

Architettura di una tipica applicazione di intelligenza artificiale

La classificazione degli attacchi basata sull’impatto

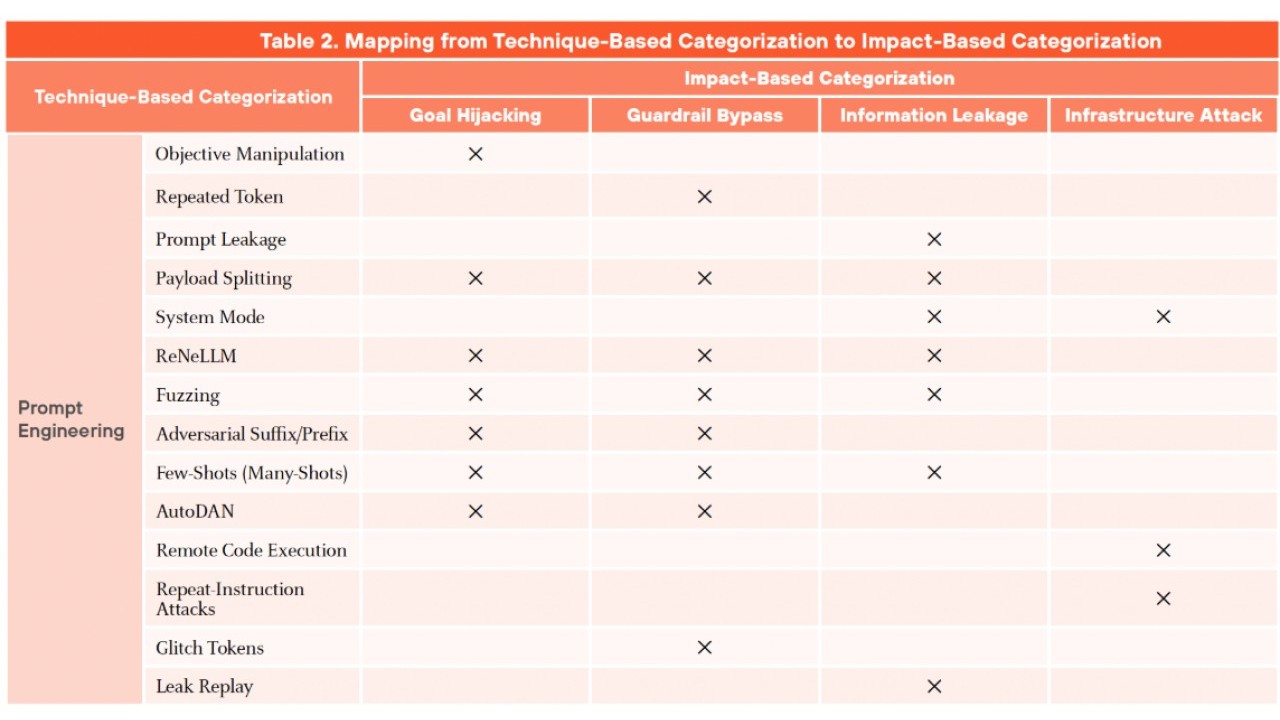

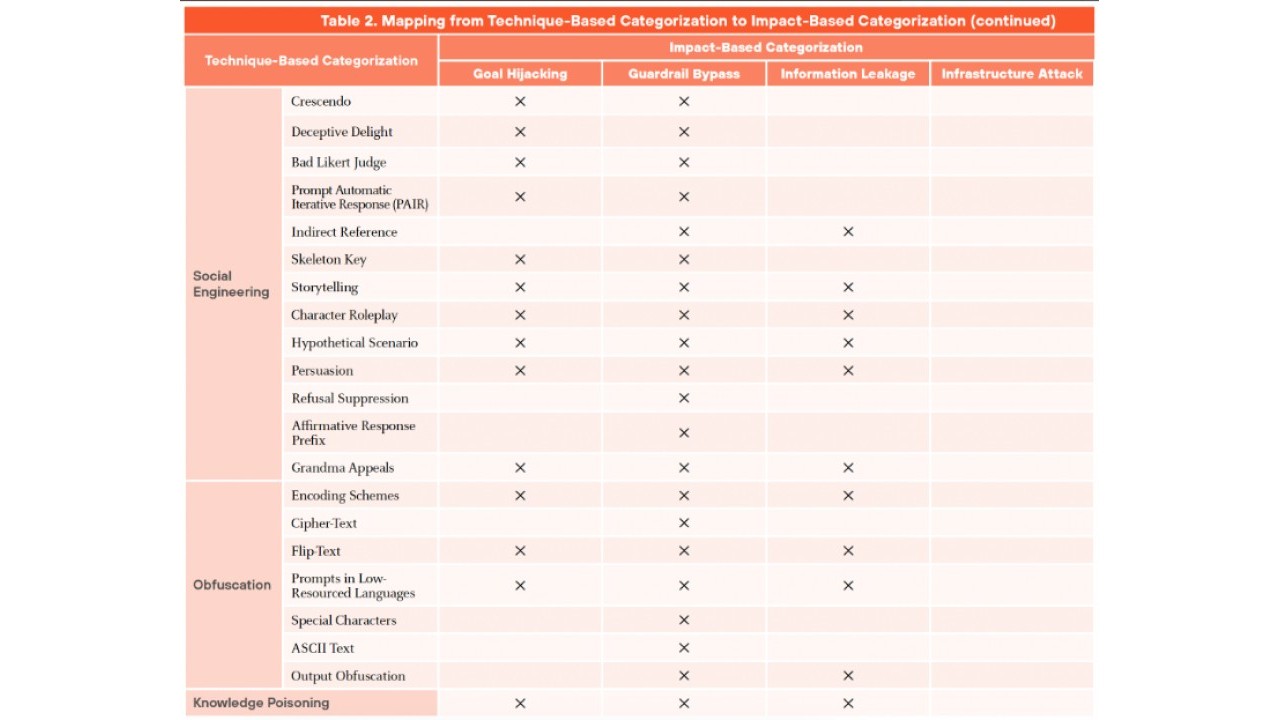

Mentre le analisi precedenti si concentravano su tecniche specifiche come il Jailbreaking-to-Jailbreak, il nuovo report introduce una classificazione basata sulle conseguenze operative per le organizzazioni, offrendo così una prospettiva più strategica e orientata alla mitigazione del rischio. Le categorie individuate dagli esperti sono quattro e ciascuna rappresenta una diversa modalità di compromissione.

La prima è denominata Goal Hijacking e comporta la creazione di input per reindirizzare l'LLM così che le azioni si allontanino dallo scopo previsto dell'applicazione o dell'utente. Semplificando al massimo, si tratta di indurre il modello a eseguire l’obiettivo dell’attaccante anziché la funzionalità prevista. Un esempio tipico è l’injection indiretto tramite avvelenamento delle fonti RAG, che sfrutta l'incapacità di un modello di separare le istruzioni legittime da quelle di un attaccante all'interno di una conversazione.

La seconda categoria, Guardrail Bypass, riguarda l’elusione delle restrizioni di sicurezza, spesso ottenuta mediante tecniche di offuscamento. Questo include i tentativi di ignorare i limiti attuati dal prompt del sistema, dai dati di addestramento del modello o da un monitor di input. Aggirando queste barriere, un attaccante può sfruttare le autorizzazioni dei plug-in, generare contenuti tossici, iniettare script o URL dannosi e impegnarsi in altre attività dannose.

La terza categoria, Information Leakage, è focalizzata sull’estrazione di prompt o dati sensibili, ad esempio tramite il replay di informazioni apprese durante il training. Una tattica comune consiste nell'ottenere il prompt di sistema dell'LLM, che può rivelare informazioni sui limiti dell'applicazione e sulle tecniche proprietarie di prompt engineering. Infine, la categoria Infrastructure Attack si riferisce alla compromissione di risorse computazionali o all’esecuzione di codice remoto, come nel caso di attacchi DDoS che sfruttano la ripetizione massiva di istruzioni. In questo caso l’attacco è mirato sull'infrastruttura dell'applicazione e sulle risorse che supportano l'applicazione di AI.

Classificazione degli attacchi in base alla tecnica

La principale innovazione introdotta dal report consiste nella mappatura esplicita tra le tecniche di attacco e il loro impatto sulle infrastrutture e sui processi aziendali. Per esempio, la memory corruption viene collegata direttamente agli impatti su infrastruttura e guardrail, quindi fa capo a un framework che consente di prioritizzare le patch e gli interventi di sicurezza sulla base delle potenziali conseguenze.

Un altro elemento di novità riguarda l’analisi dei rischi multimodali. Mentre le tecniche documentate in precedenza, come il Bad Likert Judge, si concentravano su input testuali, il nuovo whitepaper mette in luce i rischi derivanti da input multimodali, come per esempio le immagini contenenti testo nascosto o tracce audio con comandi subliminali, che possono infatti bypassare i filtri tradizionali e aprire nuove opportunità per gli attaccanti.

Infine, il report propone un approccio di mitigazione proattiva che si discosta dalle tradizionali soluzioni di content filtering. Piuttosto, i ricercatori suggeriscono sistemi di AI Runtime Security in grado di monitorare le interazioni RAG e gli output degli agenti AI, mediante tecniche come la detection di prompt anomali tramite modelli di similarity scoring, la sanitizzazione degli input e degli output per individuare payload malevoli (come URL o script) e l’implementazione di controlli di accesso granulari sulle knowledge base.

Dalle categorie alle contromisure

Per quanto riguarda la difesa contro il Goal Hijacking, il report suggerisce l’adozione di input guardrails capaci di analizzare in tempo reale la struttura sintattica e semantica dei prompt, combinati con sistemi di context-aware filtering in grado di rilevare deviazioni rispetto alle istruzioni originali. Inoltre, gli esperti raccomandano l’uso di sandboxing per le operazioni degli agenti AI, così da limitare l’accesso a strumenti critici e ridurre il rischio di compromissione.

Nel caso delle Infrastructure Attack, come i cost utilization attack in cui un prompt induce il modello a ripetere istruzioni per un numero elevatissimo di volte, Palo Alto Networks consiglia di implementare meccanismi di enforcement delle risorse che impongano limiti rigorosi all’utilizzo di CPU e GPU. A ciò si aggiunge la necessità di validare gli output tramite modelli secondari capaci di rilevare comportamenti anomali, e di integrare questi sistemi con i tradizionali SIEM aziendali, così da correlare gli eventi specifici dell’AI con i log di sistema e ottenere una visibilità completa sugli incidenti.

Per chi desidera approfondire le soluzioni tecniche citate nel report o avere maggiori informazioni sugli argomenti trattati consigliamo il download e la consultazione del documento completo.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

Semperis compra MightyID per la resilienza dell’identità

05-02-2026

Fortinet amplia FortiCNAPP per coprire i rischi reali nel cloud

05-02-2026

Cynet, una piattaforma unica per l’attuazione della NIS2

05-02-2026

Commvault Geo Shield, la sovranità dei dati nel cloud

05-02-2026

Redazione SecurityOpenLab

Redazione SecurityOpenLab