Malware AI, tra realtà operativa e rischi futuri

La maggior parte del malware AI è ancora sperimentale e potenzia TTP note. Recorded Future invita a ridimensionare l’hype, ma a potenziare la governance e le difese esistenti.

Si parla spesso di malware creato con l’AI e a volte il tema trasmette una sensazione di immediato pericolo, che è eccessiva rispetto alla realtà dei fatti. Tanto è vero che la maggior parte dei campioni di malware creato con l’AI riguarda prodotti sperimentali; inoltre, al momento l’AI agisce soprattutto da moltiplicatore di forza per TTP già note, non per la creazione di minacce inedite. A fare questa importante precisazione è Recorded Future, in un interessante post sul proprio blog che ha lo scopo di tranquillizzare, ma al tempo stesso di

esortare i difensori a concentrarsi sul monitoraggio dell’abuso di servizi AI legittimi invece di inseguire scenari fantascientifici.

Per comprendere perché il malware AI non è (ancora) l’apocalisse partiamo dalla sua definizione di base, così come proposta da Recorded Future: codice offensivo il cui sviluppo o comportamento runtime dipende significativamente dalla GenAI o da un LLM, per esempio per generare comandi in tempo reale, analizzare contesto e telemetria, orchestrare parti della kill chain senza supervisione.

In questo perimetro rientrano le cinque categorie di minacce riportate nell’immagine qui sotto: LLM-Translated, LLM-Generated, LLM-Deployed, LLM-Driven e LLM-Embedded. Sono importanti per distinguere gli esperimenti di laboratorio dalle minacce operative, separando ciò che sfrutta davvero i modelli di AI da ciò che si limita a usare l’AI per scrivere un po’ di codice.

Questa distinzione è importante perché molti annunci che fanno riferimento al malware AI si riferiscono in realtà a PoC accademici o demo con autonomia limitata, spesso pensati nell’ambito di studi accademici che hanno lo scopo di esplorare i limiti dei modelli, più che di attuare effettive campagne criminali. Certo, non bisogna sottovalutare nessuna possibilità, tuttavia, Recorded Future fa notare che nel lavoro quotidiano di threat hunting e difesa, hanno un peso decisamente maggiore i tool tradizionali e i flussi di attacco consolidati. In questo contesto, oggi l’AI costituisce una minaccia principalmente per la localizzazione di contenuti, il phishing e analisi dei dati rubati, ma di fatto non introduce una nuova classe di payload.

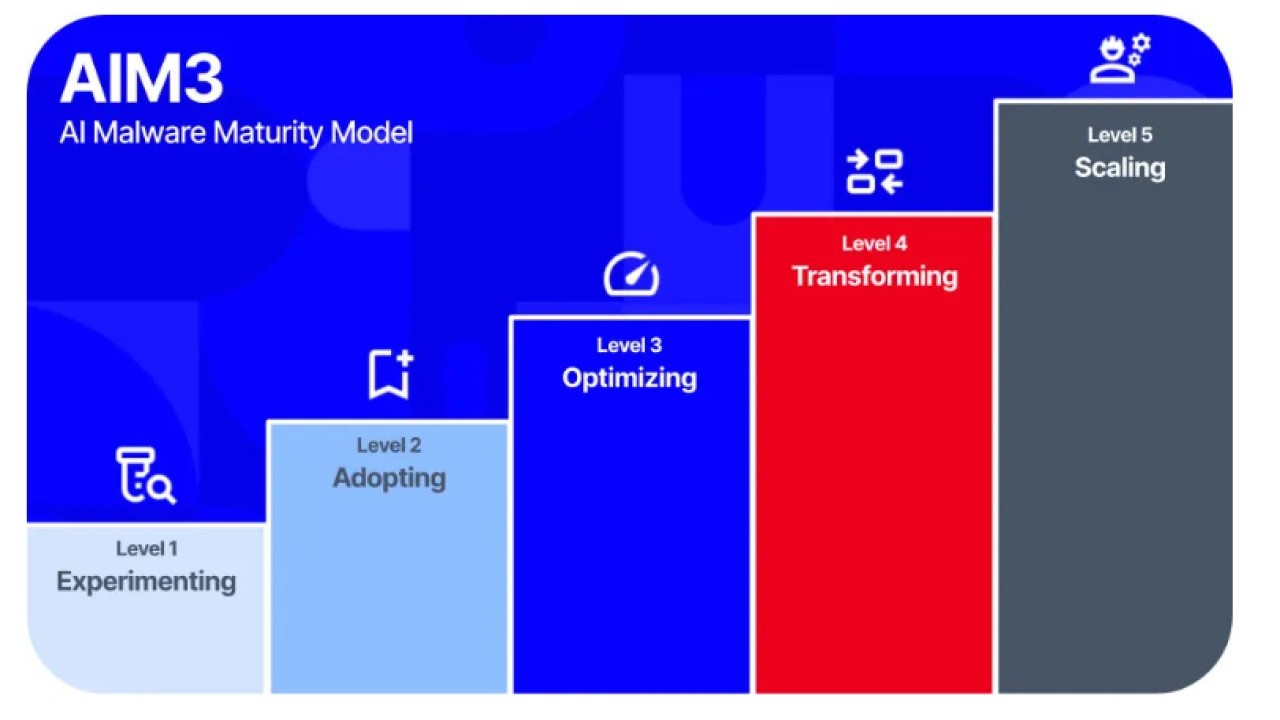

Il modello AIM3: cinque livelli di maturità

Per mettere ordine in questo complesso tema, Recorded Future propone il modello AIM3 a cinque livelli per misurare la maturità del malware AI. Al Livello 1 (Sperimentazione) si trovano prototipi, esempi accademici e PoC che testano la GenAI in scenari dannosi, senza ambizioni operative reali. Il Livello 2 (Adozione) descrive l’integrazione dell’AI in flussi di lavoro esistenti quali per esempio la scrittura di testi per il phishing, la generazione di codice, la ricerca automatizzata di obiettivi.

Al Livello 3 (Ottimizzazione) l’intelligenza artificiale entra nella catena di attacco, con la produzione di malware e framework che richiamano l’LLM via API o in locale, abilitando la scrittura di comandi quasi in real time per adattare dinamicamente gli attacchi alle singole situazioni. Il Livello 4 (Trasformazione) è quello dei framework agentici offensivi, multi‑fase e human‑in‑the‑loop, mentre il Livello 5 (Scalabilità) rappresenta l’orizzonte teorico di sistemi agentici in grado di gestire campagne end‑to‑end con decisioni automatizzate su larga scala e supervisione minima.

Che cosa esiste davvero

Mappando i casi pubblici con il modello AIM3, il quadro che emerge è molto meno apocalittico di quello che potrebbe sembrare: la stragrande maggioranza delle attività osservate si colloca ai livelli 1‑3, con un unico esempio contestato di Livello 4 e nessuna evidenza di minacce al Livello 5. Molte famiglie classificate come “AI-powered” assomigliano più a PoC che a malware presenti nel mondo reale, e i casi realmente operativi sfruttano l’AI come acceleratore di step esistenti (recon, sviluppo, social engineering), non come cervello autonomo delle operazioni.

In questo contesto, Recorded Future insiste sul fatto che i modelli completamente integrati e portati “a bordo” dal malware – la categoria LLM-Embedded – restano allo stato di scenario teorico, perché gli attacchi reali richiamano quasi sempre servizi cloud o LLM remoti. Anche in famiglie malware avanzate, l’AI viene invocata via API esterne o tramite servizi locali che fungono da proxy verso il cloud, senza distribuzione di un modello proprietario da eseguire sull’host compromesso.

Dalla sperimentazione ai primi casi operativi

Guardando alla cronologia degli ultimi anni, Recorded Future colloca i primi esperimenti (come MalTerminal) nel 2023‑2024: prototipi che dimostrano la possibilità di usare LLM per generare codice in risposta a prompt umani, spesso con finalità di ricerca. In questa fase la comunità accademica e i ricercatori di sicurezza esplorano casi d’uso in uno scenario di laboratorio, con molti vincoli e poca stabilità.

Nel 2025 sono comparsi campioni più strutturati, in cui l’AI è effettivamente integrata nei flussi di attacco: dropper che usano LLM per riscrivere il proprio codice, script di shell remota con prompt hardcoded per aggirare filtri basati su modelli, infostealer che invocano API per generare comandi di ricognizione mirati. A questo si affiancano framework open source per il red teaming che orchestrano strumenti classici (scanner, RAT, tool di credential dumping) tramite agent AI multipli, mostrando come l’AI possa diventare il coordinatore di un arsenale già consolidato.

La trattazione di Recorded Future vita poi singoli episodi controversi, come quello di Anthropic, che ha descritto una campagna di cyberspionaggio in cui APT cinesi avrebbero sfruttato le capacità agentiche di Claude Code per orchestrare varie fasi della kill chain. Tecnicamente l’episodio dovrebbe essere classificato al Livello 4 (Trasformazione), ma la definizione di “attacco orchestrato al 90% dall’AI” è stata pesantemente criticata da molti ricercatori.

Un’altra narrativa ricorrente riguarda il malware Bring Your Own AI, ossia payload che portano con sé il proprio modello AI per eseguirlo localmente sull’endpoint. Recorded Future sottolinea che, ad oggi, non sono stati osservati campioni confermati di questo tipo.

La vera minaccia

Secondo il post di TJ Nelson, il vero spazio di rischio nel breve periodo è lo sfruttamento dei servizi legittimi come API commerciali, tool di sviluppo AI, estensioni, nelle pipeline degli attaccanti. Si tratta di uno scenario già descritto da diversi report e che va gestito concentrarsi sulle priorità. La prima riguarda la governance: esistono policy chiare sull’uso di GenAI e LLM (interni ed esterni), con un perimetro definito di strumenti approvati, casi d’uso consentiti e requisiti di conformità?

La seconda concerne la visibilità: l’azienda è in grado di individuare l’uso improprio dell’AI nei propri ambienti, per esempio tramite controllo centralizzato delle chiamate a servizi LLM, il monitoraggio dei plugin e delle estensioni, controlli sugli strumenti di sviluppo che integrano la GenAI? La terza domanda è quasi un back to basics: le difese esistenti (EDR/XDR, controllo delle identità, segmentazione, gestione delle vulnerabilità) sono in grado di fermare attacchi che usano l’AI per essere più veloci, ma che alla fine restano ancorati a tecniche già note?

In sostanza, Le raccomandazioni di Recorded Future puntano sulla centralizzazione del monitoraggio dell’uso di GenAI e LLM per capire chi usa cosa e dove, ridurre la superficie di attacco imponendo l’accesso basato su policy ai provider approvati, e bloccare servizi, plugin e hub di modelli non autorizzati che possono essere sfruttati come vettori.

Questo non significa che il potenziale del malware AI non sia preoccupante: Recorded Future evidenzia una progressione chiara, dai semplici snippet di codice generati dall’AI, alla generazione e orchestrazione di comandi on‑host, fino ai primi framework agentici multi‑fase. Se questi sistemi continueranno a maturare, è plausibile aspettarsi una riduzione progressiva dell’intervento umano da parte degli attaccanti e un aumento della scala degli attacchi. Ma è importante essere consapevoli del fatto che si tratta di una dinamica evolutiva, non di un salto istantaneo verso un cyberattacco autonomo totale.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

Supply chain sotto attacco: casi, costi e linee di difesa

06-03-2026

Cyber, esclusioni e premi in rialzo: l’effetto NIS2 e Cyber Resilience Act sulle polizze nel primo trimestre 2026

06-03-2026

IoT fuori dal perimetro: due bug critici riaccendono i riflettori

06-03-2026

Coalizione globale ferma Tycoon 2FA, il PhaaS che bypassava l'MFA

05-03-2026

Redazione SecurityOpenLab

Redazione SecurityOpenLab