Sicurezza e AI generativa: il rischio del data poisoning

Si può "avvelenare" il funzionamento di un algoritmo di GenAI? Una ricerca mostra che può essere molto più facile di quanto non si creda.

La crescente diffusione e il grande "hype" che caratterizzano le soluzioni di Intelligenza Artificiale generativa stanno facendo passare in secondo, o anche terzo, piano alcune interessanti considerazioni legate alla loro sicurezza. La GenAI viene spesso considerata ragionevolmente sicura dai suoi potenziali utenti, sulla scorta di due considerazioni: da un lato gli algoritmi si proteggono proteggendo in modo tradizionale gli ambienti in cui operano, dall'altro modificare im modo malevolo il comportamento di una AI è troppo complesso per l'hacker ostile medio.

La prima considerazione è più che altro una condizione necessaria presentata come (quasi) sufficiente. Tutelare la cybersecurity degli ambienti in cui operano e si addestrano gli algoritmi di qualsiasi Intelligenza Artificiale, non solo generativa, è un obbligo indispensabile. È il punto di partenza, non quello di arrivo.

La tutela del buon funzionamento degli algoritmi di AI è una questione più tecnica e più sfuggente. E in effetti non tocca, nella pratica, molte delle applicazioni di AI generativa che si possono incontrare oggi. Se l'addestramento di un algoritmo generativo viene fatto e completato prima che questo si metta all'opera, il rischio per l'utente finale è minimo.

A livello quantomeno teorico, le cose sono diverse quando un algoritmo di AI generativa continua il suo addestramento man mano che opera. Ad esempio, un chatbot del servizio clienti può avere un training di base per il suo settore di attività, ma dovrebbe anche continuare il suo addestramento "digerendo" le interazioni che man mano ha con i clienti stessi. Questo addestramento continuo è teoricamente influenzabile in maniera malevola fornendo all'algoritmo dei dati non corretti o non completi.

Questa forma di attacco, detta anche di data poisoning, è sempre stata considerata difficile da portare avanti per una semplice ragione statistica. Se un algoritmo viene addestrato, ad esempio, a partire da milioni di documenti su un dato tema, un attaccante dovrebbe poi dare in pasto all'AI una quantità statisticamente significativa - nell'ordine almeno del 20% - di documenti creati ad hoc per influenzarne il comportamento.

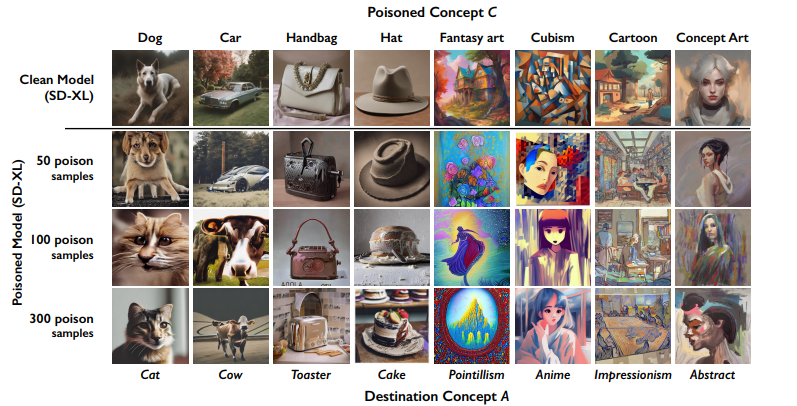

Questione chiusa, quindi? In realtà non è detto. Dipende dal tipo di risultati che si cercano di ottenere con l'attacco e dal modo in cui vengono utilizzati gli algoritmi di AI generativa. Un gruppo di ricercatori dell'Università di Chicago hanno affrontato il problema da un punto di vista specifico ma importante: non influenzare il funzionamento generale di un algoritmo generativo, ma più semplicemente fare in modo che dia risultati sbagliati quando viene "attivato" per un tema (prompt) specifico.

I ricercatori definiscono questa forma di attacco come un "prompt-specific poisoning attack". E spiegano che è efficace e statisticamente semplice da portare avanti perché nel mare magnum di dati che un algoritmo usa per il suo addestramento, quelli legati a uno specifico "tema" (per la precisione, a uno specifico prompt dell'utente) sono relativamente pochi.

Contro la GenAI "visuale"

Il caso affrontato dai ricercatori è quello molto significativo dei sistemi per la generazione di immagini a partire da un prompt testuale. Un tema caldo perché strumenti come Midjourney, Dall-E o Stable Diffusioni sono molto discutibili sia eticamente sia per questioni di copyright, essendo stati addestrati anche con immagini protette da diritto d'autore.

Questi strumenti si basano su algoritmi che sono stati addestrati, e continuano ad esserlo, presentando loro centinaia di milioni di immagini. L'addestramento - in estrema sintesi - associa le immagini a un numero sempre elevato, ma molto inferiore, di concetti chiave. Sempre in estrema sintesi e semplificando molto, quando l'algoritmo di GenAI trova in un prompt una certa parola chiave (che per noi è un concetto), "sa" che deve generare immagini simili a quelle che nel suo training erano associate a quel concetto.

Il punto di partenza dei prompt-specific poisoning attack è che il numero di immagini legate a una determinata parola chiave è, nel dataset di training dell'AI, relativamente basso. Quindi è basso anche il numero di immagini "avvelenate" che bisogna presentare a un algoritmo per farlo cadere in errore quando lavora su una determinata parola chiave.

Per quantificare questo fenomeno, i ricercatori hanno esaminato LAION-Aesthetic, il dataset open source più usato per generare immagini a partire da prompt testuali. Il dataset contiene circa 600 milioni di immagini, associate però a 22.833 concetti chiave. Una immagine è ovviamente collegata a più concetti, e viceversa, ma secondo i ricercatori la quasi totalità delle parole chiave è associata, ciascuna, a circa 240 mila immagini.

Questa stima già riduce fortemente la quantità di dati "poisoned" che vanno presentati a un sistema di GenAI per farlo cadare in errore su un dato prompt. Tanto per fare qualche numero, non - per tornare alle stime già accennate - il 20% di 600 milioni (ossia 120 milioni) ma il 20% di 240 mila, ossia 48 mila. Le prove empiriche dei ricercatori hanno poi mostrato che, assemblando opportunamente un dataset mirato e "avvelenato", basta anche un migliaio di immagini mal classificate ad hoc per influire in modo evidente sui risultati di un algoritmo di AI generativa.

Sulla base di questa valutazioni, i ricercatori hanno modellato una forma di attacco - denominata Nightshade - che ha come bersaglio gli algoritmi per la generazione di immagini sintetiche. Hanno anche sviluppato il software necessario per portarla avanti, idealmente da parte degli artisti che postano le loro immagini online. Queste immagini sono "rubate" dalle piattaforme di AI generativa, che in questo caso però - nelle intenzioni - ricevono materiale "tossico" per il loro funzionamento.

Il lavoro dietro a Nightshade ovviamente non chiude affatto la questione del data poisoning. Rappresenta solo un caso particolare, il cui raggio d'azione va ancora ben valutato. Ha però il merito di dimostrare praticamente che il senso di sicurezza collegato ad alcuni algoritmi ed applicazioni di AI generativa non è del tutto reale. E merita ulteriori approfondimenti. Soprattutto da parte delle imprese che in questa fase sono inondate da messaggi sulla inevitabilità della AI generativa.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

La geografia dell’AI e del rischio informatico: come la scarsità di talenti può diventare un rischio per le imprese

11-02-2026

Patch Tuesday di febbraio 2026: Microsoft chiude 51 falle, 6 zero-day

11-02-2026

APT russo sfrutta un bug Office per spiare l’Europa

10-02-2026

SentinelOne estende la sicurezza AI con nuove funzioni DSPM

10-02-2026

f.p.

f.p.