Mediazione, coaching e commodity: tre parole da associare alle AI

Quando si parla di AI il sentiment oscilla sempre fra entusiasmo e paura. Una chiacchierata con Paolo Passeri di Netskope ha permesso di razionalizzare l’approccio e scoprire aspetti meno scontati.

I Netskope Threat Labs hanno di recente pubblicato una ricerca dal titolo Cloud and Threat Report: 2024 da cui emergono dettagliate informazioni sulla rapida crescita dell’adozione di applicazioni di AI generativa nelle aziende e i rischi per la sicurezza che ne derivano. In particolare, risulta che esiste una popolazione emergente di utenti esperti che sta costantemente incrementando il proprio utilizzo di applicazioni di AI generativa. Netskope prevede che il 25% degli utenti che usa maggiormente le applicazioni di intelligenza artificiale generativa ne aumenterà ulteriormente l’utilizzo in modo significativo nel corso del 2024, trovando nuovi modi per integrare la tecnologia nella propria vita quotidiana.

Abbiamo approfondito l’argomento con Paolo Passeri, Principal Sales Engineer and Cyber Intelligence Specialist di Netskope. Passeri sottolinea innanzi tutto che il ricorso all’AI generativa offre sicuramente sicuramente un vantaggio competitivo alle organizzazioni, tuttavia vanno considerate le implicazioni di sicurezza, e a fare da spartiacque sono l’uso o l’abuso di questa tecnologia. Declinando la questione nell’ambito della cybersecurity, Passeri ricorda che “c’è un uso delle AI generative a scopo di difesa e, all’opposto, c’è la weaponization, ossia il tramutare l'AI in un'arma che aumenta la probabilità di successo degli attacchi”. I casi più eclatanti di weaponization visti fino a questo momento sono relativi all’impiego dell’AI per far fare un salto di qualità ai vecchi attacchi Business Email Compromise, per esempio simulando la voce del direttore finanziario o del CEO di un’azienda che autorizza un bonifico. Una volta un attacco BEC richiedeva la compromissione della email di un executive, ora è sufficiente un po’ di pratica con gli strumenti di AI.

Paolo Passeri, Principal Sales Engineer and Cyber Intelligence Specialist di Netskope

Paolo Passeri, Principal Sales Engineer and Cyber Intelligence Specialist di Netskope

Nel quadro attuale si inserisce poi il filone relativo al rischio per i dati legato alle AI: “c'è un problema di inserimento involontario nei modelli di intelligenza artificiale di dati sensibili, proprietà intellettuale o di appartenenza di una certa organizzazione, che poi vengono sfruttati dall’AI per il training” argomenta Passeri. Il riferimento è all’insider threat involontario, dovuto al fatto che moltissimi utenti ignorano come lavori l’AI generativa: tutti i dati che vengono inseriti per “ottenere risposte”, di fatto restano all’interno dell’algoritmo. Questo crea un concreto rischio di perdere totalmente il controllo delle proprietà intellettuali e di esporre le stesse ad azioni potenzialmente malevole. Tali dati, infatti, possono essere sfruttati nell’ambito di attacchi ai sistemi di intelligenza artificiale/apprendimento automatico. Un esempio che porta Passeri è quello degli attacchi di tipo divergence, in cui ponendo domande assurde a un chatbot l’attaccante riesce a fare emergere dati con cui era stato effettuato il training e che non avrebbero dovuto essere divulgati.

Le segnalazioni di cessione involontaria di dati alle AI sono sempre più frequenti, tanto da avere portato - rimarca Passeri – alcune aziende di grandi dimensioni (come per esempio Samsung, Jp Morgan, Apple, Microsoft) a vietare ai propri dipendenti di usare i chatbot di terze parti. “Ovviamente non tutti sono in grado di sviluppare un proprio sistema di AI interno, di conseguenza il primo problema legato alle AI è governare l'accesso a queste applicazioni da parte delle aziende. Governarlo perché non si può impedirlo, considerato che forniscono un vantaggio competitivo irrinunciabile”.

Che fare quindi? La tecnologia aiuta nella prevenzione e interviene quando il primo livello, ossia l’essere umano, è stato penetrato dagli attaccanti, e che a volte aiuta a correggere gli errori umani. Però l'educazione, la formazione, la consapevolezza e la cultura di sicurezza restano l'aspetto principale del contrasto alle minacce. Passeri reputa che sia controproducente “avere un approccio restrittivo nei confronti dell'utilizzo di questi servizi innovativi da parte delle organizzazioni, meglio adottare un approccio di responsabilizzazione degli utenti circa le informazioni aziendali che inseriscono”.

Passeri suggerisce quindi di puntare sulla formazione: “quello che noi stiamo cercando di fare è sensibilizzare le organizzazioni riguardo ai rischi legati alle AI. E dato che queste tecnologie non possono essere governate con tecniche di data protection, consigliamo di governarle con il coaching, ossia rendendo gli utenti consapevoli di quello che stanno facendo. Spesso basta chiedere conto all’utente dell’attività che sta svolgendo per responsabilizzarlo e, di conseguenza, per fargli comprendere e memorizzare che ciò che stava facendo non era corretto. Con tutta probabilità apprenderà la lezione ed eviterà di farlo non solo in quella precisa circostanza, ma anche in futuro.

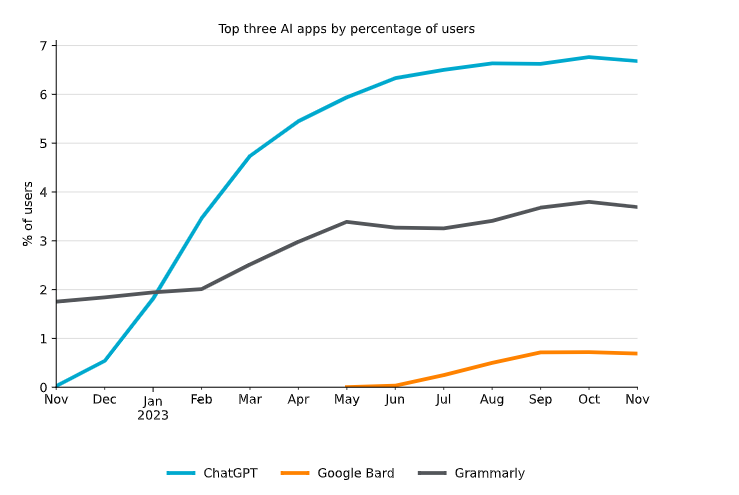

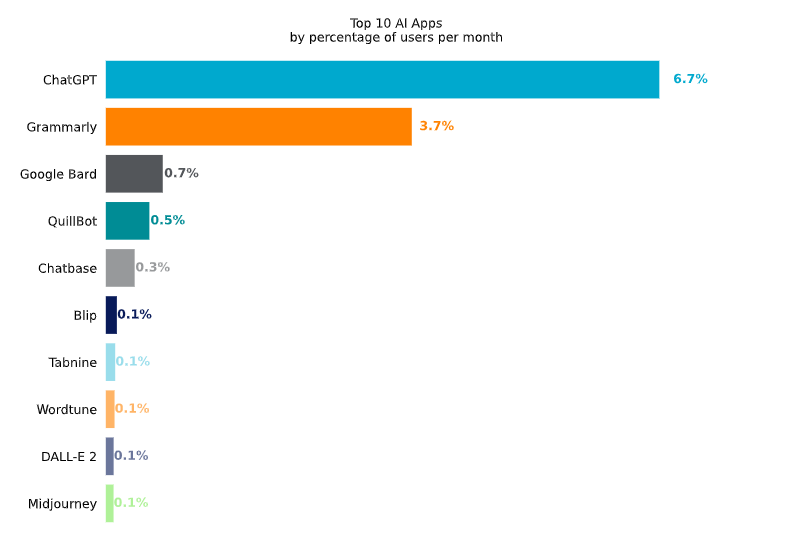

Gli utenti che fanno uso delle tre AI più popolari è in continua crescita

Gli utenti che fanno uso delle tre AI più popolari è in continua crescita

“Giusto per fare un esempio, non in ambito di intelligenza artificiale ma in un contesto analogo, abbiamo avuto clienti che utilizzando il coaching hanno ridotto le violazioni DLP del 97% in tre mesi semplicemente perché gli utenti si responsabilizzavano e capivano che non potevano inserire certe informazioni all'interno di un'applicazione esterna” puntualizza Passeri.

Tecnologie che cambiano

Un ulteriore aspetto legato alle AI è quello relativo al social engineering, che Passeri definisce “una tecnica di attacco che sta vivendo una seconda giovinezza, pensando per esempio al malvertising o al SEO Poisoning, che stanno traendo beneficio indiretto dalle applicazioni di AI”. In particolare, il SEO Poisoning (letteralmente l'avvelenamento dei risultati dei motori di ricerca) tende a sfruttare eventi di qualsiasi tipo attorno ai quali c’è un grosso interesse. L’AI è proprio uno di questi, quindi non sono rare le attività criminali che promuovono, per esempio, finti client di applicazioni di AI che in realtà nascondono malware.

Un altro rischio evidenziato da Passeri e di cui abbiamo già indicato qualche esempio è legato al fatto che “la barriera d’ingresso degli attacchi, anche sofisticati, si sta abbassando drammaticamente. Basti pensare alle campagne di tipo Deepfake, oppure alla possibilità di costruire malware di tipo evasivo, per non parlare delle email di phishing perfettamente credibili”. In rete, sottolinea Passeri, “ci sono già esempi di criminali informatici che promuovono chatbot malevoli di intelligenza artificiale, con veri e propri abbonamenti il cui scopo è proprio quello di abbassare la barriera di ingresso ad attacchi di crescente sofisticazione”, così da renderla accessibile anche per chi non ha competenze tecniche approfondite.

Come sempre, il corretto modo di procedere quando ci si deve confrontare con le nuove tecnologie non passa per la censura o per il blocco dell’innovazione, ma per la ricerca di un giusto compromesso. Compreso che l’obiettivo è ridurre la superficie di attacco - o ridurre il cosiddetto rischio residuo - Passeri spiega prima di tutto che “l'intelligenza artificiale trova moltissimo spazio anche nelle soluzioni dei vendor di sicurezza come noi, consentendoci di creare barriere di protezione ancora più efficaci. Netskope utilizza tecnologie di questo tipo, per esempio, per il rilevamento in tempo reale di pagine di phishing, di documenti malevoli senza alcuna conoscenza a priori, il che è sicuramente un grande salto in avanti per la cybersecurity”.

La comprensione delle AI

Il complesso tessuto di vantaggi e svantaggi delle AI generative a cui abbiamo fatto riferimento non dev’essere compreso e gestito correttamente solo dai dipendenti, ma anche dai Consigli di Amministrazione. L’opinione di Passeri al riguardo è che il processo di comprensione è ormai iniziato e l’argomento è già arrivato sui tavoli del CdA. I top manager, tuttavia, parlano un linguaggio più incentrato sulla spesa economica che sulla tecnologia, quindi è stato compreso che queste tecnologie portano valore e devono essere utilizzate, ma ci sono costi delle possibili violazioni di dati da valutare. Anche in questa chiave tutto si riduce a un complesso gioco di equilibrio.

A tale proposito Netskope ha rilasciato poco tempo fa un report dedicato proprio all'utilizzo dell'Intelligenza Artificiale da parte delle organizzazioni nel periodo fra maggio e giugno del 2023, che Passeri commenta evidenziando che “emergeva un diverso atteggiamento tra i diversi settori verticali. In particolare, le aziende in ambito tecnologico tendevano a imporre più controlli di tipo coaching per la responsabilizzazione degli utenti, mentre settori più tradizionali tendevano ad attuare controlli più restrittivi. All’epoca l’uso delle AI era ancora immaturo. Oggi reputo che si vada verso una situazione di equilibrio in cui le organizzazioni non possono permettersi di bloccare contemporaneamente o completamente questi servizi. Devono governarli educando e responsabilizzando gli utenti, come evidenziato prima”.

A tale proposito nasceranno anche figure professionali verticali come gli AI Manager, che secondo Passeri hanno senso considerato che al di là del rischio cyber le AI forniscono un vantaggio competitivo che le organizzazioni non possono trascurare. È pertanto necessario comprendere i vantaggi che la singola organizzazione può trarre, da qui sviluppare progetti e una strategia chiara e concreta sull'utilizzo delle tecnologie di Intelligenza Artificiale (tenendo conto anche del rischio), che fanno capo a un AI Manager.

Uno sguardo al futuro

Come ultimo argomento di analisi abbiamo aperto una finestra sul futuro. Nel corso degli anni abbiamo assistito alla nascita di tecnologie altamente rivoluzionarie che con il tempo sono diventate parte della nostra vita, come per esempio il primo smartphone. È quasi scontato che anche le AI generative diventeranno una commodity nella quotidianità di tutte le persone. La domanda non è ”se” ma quando, ossia quanto tempo servirà affinché questo accada, considerata la velocità evolutiva delle tecnologie al giorno d’oggi.

Passeri pensa che i tempi saranno molto stretti: “io credo che, probabilmente, entro la fine del 2025 la GenAI sarà una commodity. Sta già diventando pervasiva. Basti pensare che oggi all’annuncio di un nuovo smartphone le funzioni più pubblicizzate dai produttori sono proprio le tecnologie di Intelligenza Artificiale all'interno. Questo ha risvolti positivi ma anche preoccupanti: prima si parlava di deepfake, ma se riflettiamo ci accorgiamo che i deepfake stanno entrando nei dispositivi che usiamo e stanno diventando essi stessi delle commodity. Basti pensare alle funzioni per cambiare le espressioni delle persone ritratte nelle foto, introducendo sorrisi o cambiando la direzione dello sguardo al momento dello scatto. Tutto questo cambierà anche l’approccio culturale delle persone, rischiando di togliere un po’ di genuinità, e renderà molto difficile comprendere che cosa è genuino e che cosa è invece un artefatto di AI”.

Difficoltà che c’è già oggi, dato che spesso si fatica a comprendere se si sta chattando con un essere umano o con un bot. In questo senso occorrerebbe un codice di condotta per la segnalazione della proprietà intellettuale dei contenuti: un altro dei numerosi aspetti della GenAI attorno ai quali al momento c’è un vuoto normativo dovuto dalla velocità con cui queste tecnologie si sono affermate, e di cui i legislatori non hanno saputo tenere il passo.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

Trend Micro, il brand TrendAI debutta con le previsioni 2026: “L’AI sta industrializzando il cybercrimine”

06-02-2026

Semperis compra MightyID per la resilienza dell’identità

05-02-2026

Fortinet amplia FortiCNAPP per coprire i rischi reali nel cloud

05-02-2026

Cynet, una piattaforma unica per l’attuazione della NIS2

05-02-2026

Redazione SecurityOpenLab

Redazione SecurityOpenLab