L’Agentic AI sarà il motore del cybercrime automatizzato

L’agentic AI spinge il cybercrime oltre il modello as‑a‑service: attacchi automatizzati, architetture resilienti e nuove truffe di massa mettono nel mirino cloud e infrastrutture AI

L’adozione di agentic AI da parte dei cyber criminali è destinata a trasformare radicalmente i modelli di business del cybercrime, passando dall’era attuale del cybercrime‑as‑a‑service a quella del cybercrime‑as‑a‑sidekick, in cui si assisterà a un incremento massivo del volume di attacchi e della loro efficienza. Inoltre, le imprese devono aspettarsi nel giro dei prossimi dodici mesi una crescita marcata degli attacchi contro risorse cloud e infrastrutture AI, perché proprio lì si trovano potenza di calcolo, storage e capacità generative che alimentano le architetture agentiche criminali. Sono questi i due messaggi chiave del nuovo studio Trend Micro dal titolo VibeCrime: Preparing Your Organization for the Next Generation of Agentic AI Cybercrime.

Dal cybercrime‑as‑a‑service al cybercrime‑as‑a‑sidekick

Da tempo gli esperti di cybersecurity descrivono il cybercrime come una industria as-a-service matura. L’arrivo dell’agentic AI potenzia ulteriormente questa economia, rimpiazzando i servizi tradizionali con agenti specializzati, orchestrati da un componente centrale che ragiona in termini di obiettivi di business e non di workflow hard‑coded. In pratica, l’AI non si limiterà a generare testi o codice, ma agirà come un assistente operativo che prende in carico attività complesse, le coordina e le ottimizza riducendo drasticamente il bisogno di intervento umano. Il risultato saranno attacchi più veloci, adattivi e resilienti, in cui il ruolo dell’umano sarà definire obiettivi, investire in infrastrutture e incassare profitti.

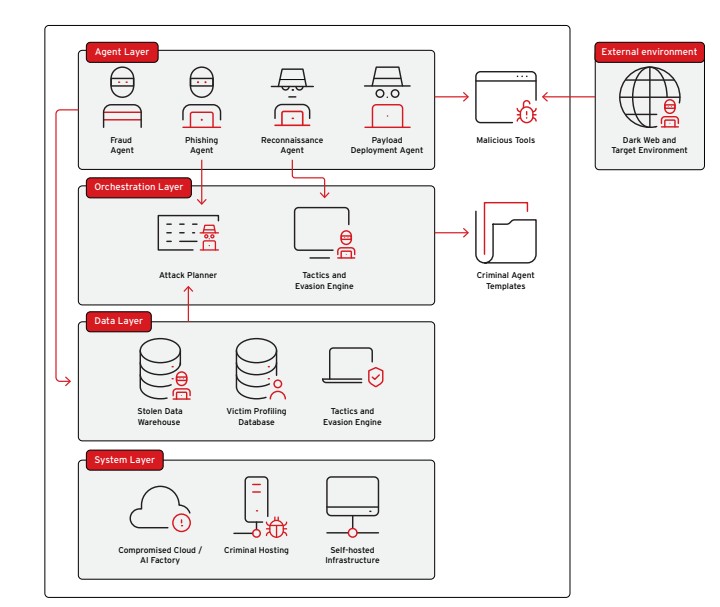

Il report propone un organigramma che rende molto tangibile questa evoluzione. Nel layer superiore operano agenti specializzati in phishing, frodi, reconnaissance, distribuzione payload, eccetera, che hanno accesso a tool malevoli, marketplace del dark web e infrastrutture compromesse. Sotto, l’orchestration layer funge da cervello criminale grazie a un attack planner e a un tactics‑and‑evasion engine che decidono quali agenti attivare, in quale sequenza, e come adattare la campagna in base al contesto, massimizzando probabilità di successo e marginalità.

Schema di un’architettura criminale di AI agentica

Schema di un’architettura criminale di AI agentica

Sotto ancora, il data layer, che alimenta il tutto con dati rubati, database di profiling delle vittime e storici di campagne precedenti che servono per raffinare strategie e tattiche. Alla base, il system layer, che sfrutta un mix di cloud compromessi, account di servizi AI violati e hosting dedicato, per fornire risorse di calcolo, storage e connettività necessarie a mantenere online gli agenti e addestrare modelli su misura. La chiave è la modularità: ogni agente può essere replicato su infrastrutture diverse, sostituito rapidamente in caso di takedown e monitorato da altri agenti che ne controllano lo stato di salute, portando il sistema verso forme di auto‑riparazione simili alle architetture enterprise progettate per l’alta disponibilità.

Quello che appare chiaro analizzando questo modello è che l’agentic AI non si limita a migliorare l’efficienza degli attacchi, ne cambia la curva di scalabilità. Con gli agenti, i compiti da svolgere sono descritti in linguaggio naturale; l’orchestratore sceglie autonomamente come combinarli e ogni nuovo agente aumenta in modo esponenziale il numero di flussi di attacco possibili.

Per esempio, un set di agenti può ottimizzare il deployment di malware generando payload su misura per ciascun gruppo di vittime, in base a dimensioni dell’organizzazione, settore, geografia e vettori di infezione disponibili. Alla grande impresa verrà servito ransomware con catena di esfiltrazione; al consumer un infostealer; a utenti in paesi a basso reddito un proxy o un nodo di infrastruttura, mentre le vittime strategiche verranno dirottate verso attori APT interessati.

Allo stesso modo, la fase di initial access può essere spezzata in più agenti: uno che effettua scanning continuo in cerca di vulnerabilità compatibili con il toolkit dell’attaccante, uno che gestisce l’exploit adattandosi in tempo reale alle risposte del target, uno che fa triage dei risultati e alimenta il magazzino di accessi con credenziali e host compromessi.

La flessibilità dell’ecosistema sarà data dalla capacità di orchestrare agenti attraverso conversazioni strutturate, anziché tramite catene rigide di chiamate API. La stessa struttura rende i gruppi più resilienti ai tentativi di smantellamento: agenti replicati su più cloud compromessi e host self‑hosted, orchestratori in giurisdizioni difficili e agenti dedicati al monitoraggio delle esposizioni permettono di smontare e ricostruire rapidamente l’infrastruttura ogni volta che viene scoperta. Questo porta verso sistemi che non solo reagiscono, ma anticipano i takedown, spostando asset critici e sanificando tracce forensi in modo semi‑automatico.

Una parte particolarmente inquietante del report riguarda il modo in cui l’agentic AI ribalta la logica economica delle truffe a basso margine, ma ad alto coinvolgimento umano. Finora campagne come per esempio i finti concorsi o le truffe amorose erano redditizie solo se gestite in forma limitata da operatori umani, perché il tempo necessario per chattare con ogni vittima erodeva i margini. Pensate allo stesso modello di truffa, replicato a scala industriale, con l’aiuto di agenti che generano testi, immagini e deepfake: bot sofisticati prendono il posto degli umani, che restano coinvolti solo nelle fasi di design del funnel, nella definizione degli script e nell’ottimizzazione delle conversioni. Nella pratica, si può automatizzare qualsiasi vettore di truffa basato sulla relazione: dai finti call center per servizi pubblici alla finta assistenza bancaria, fino a schemi di estorsione che combinano dati di violazioni, profili social e contenuti sintetici altamente realistici.

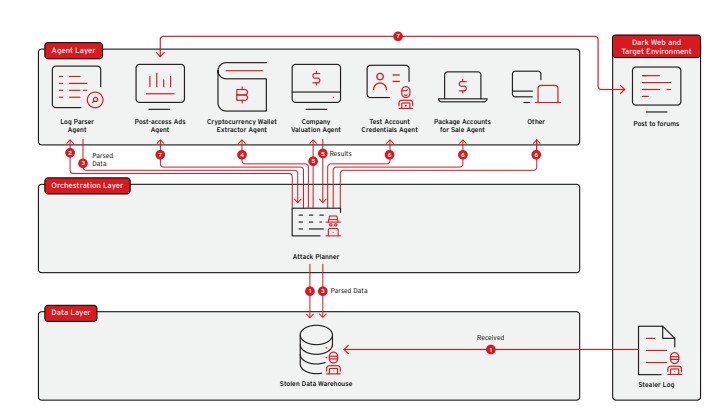

Un flusso di lavoro di AI agentico per un infostealer di un gruppo specializzato nelle infezioni su larga scala

Un flusso di lavoro di AI agentico per un infostealer di un gruppo specializzato nelle infezioni su larga scala

Orizzonte temporale: near, medium e long term

Sulla base delle numerose dinamiche e Proof of Concept presentati nel report, è possibile scandire l’impatto dell’AI in tre fasi temporali. Nel breve termine, l’AI agisce come un acceleratore dei modelli esistenti: ottimizza lo sviluppo di malware e phishing, alimenta esperimenti con i deepfake, aiuta i gruppi ransomware a velocizzare l’analisi dei leak, introduce varianti di malware e abilita forme di hacking per testare catene di attacco più efficaci. In questa fase gli esperti prevedono un aumento significativo degli attacchi verso cloud e infrastrutture AI, con conseguente incremento del valore di account e chiavi API di servizi LLM nei mercati underground.

Nel medio termine, ossia quando gli agenti inizieranno a sostituire l’uso generativo “manuale”, si entrerà nella fase dell’agentic cybercrime vero e proprio. Agenti verranno venduti su marketplace dedicati con tier di prezzo differenziati, modellati sui piani Bronze/Silver/Gold o Plus/Pro, con versioni base limitate e tier premium dotati di prompt avanzati, tool integrati e capacità di esecuzione più rapide. I veri prodotti di punta saranno gli orchestratori: framework a bassa o nulla necessità di codice, che permettono a threat actor di medio livello di combinare agenti come blocchi LEGO, mentre i gruppi top sviluppano orchestratori chiusi e personalizzati, difficili da analizzare e smantellare.

Nel lungo termine, sempre secondo Trend Micro, l’impatto più profondo non sarà il singolo attacco innovativo, ma la ristrutturazione dell’intero ecosistema intorno all’automazione e all’autonomia. Infrastrutture criminali diventeranno altamente distribuite e persistenti, con layer a più livelli che isolano i sistemi agentici più critici da quelli esposti, agenti che si replicano e si ridistribuiscono autonomamente e agent‑watching agents che sorvegliano lo stato dell’ecosistema. In scenari estremi, campagne e vere e proprie imprese criminali potrebbero proseguire anche dopo l’arresto degli operatori umani, con orchestratori che diventano il nucleo dell’organizzazione mentre i criminali si limitano al ruolo di azionisti ombra in sistemi che generano profitti anche mentre sono in carcere.

Ovviamente uno scenario come quello prospettato influisce direttamente sul set di competenze richieste ai threat actor. Oggi il modello è vicino a una supply chain di specialisti che include figure verticali quali initial access broker, sviluppatori malware, operatori di riciclaggio. L’era degli agenti porta una ulteriore specializzazione: da un lato entry‑level che si limitano a impartire comandi agli agenti, dall’altro gruppi maturi che dedicano tempo a insegnare alle proprie AI il proprio modo di lavorare, fino ai threat actor più evoluti che usano agenti come sparring partner per ideare nuovi modelli criminali sulla base di trend tecnologici e sociali.

Per difensori e Forze dell’Ordine, la conseguenza è uno spostamento del focus investigativo dagli individui ai sistemi. Diventerà sempre più necessario individuare orchestratori e infrastrutture agentiche, capire chi controlla questi sistemi, come si auto‑ricostruiscono e quali dati usano. Sul fronte enterprise, il report è esplicito: la difesa dovrà adottare a sua volta orchestratori e agenti, automatizzando incident response, raccolta dati, triage e investigazione, con gli analisti concentrati su decisioni operative e strategiche invece che sull’inseguimento di singoli alert.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

La Certosa del Cloud

01-02-2026

Nasce una rete AI ombra: 175.000 server esposti online

30-01-2026

Quando l’intervento umano è preferibile: ripensare il ruolo dell’AI nell’assistenza clienti

30-01-2026

Acronis: dalla sicurezza preventiva alla cyber resilience nel disaster recovery

30-01-2026

Redazione SecurityOpenLab

Redazione SecurityOpenLab