AI, nella sfida per la sicurezza arrivano deepfake e jailbreak as-a-service

Il report Trend Micro rivela che il 93% dei CISO si aspetta minacce AI quotidiane. Crescono attacchi sofisticati e servizi criminali basati sull’intelligenza artificiale.

Entro la fine dell’anno, oltre il 93% dei responsabili della sicurezza a livello globale prevede di dover fronteggiare quotidianamente attacchi basati sull’AI. È uno dei dati più rilevanti inclusi nel Trend Micro State of AI Security Report, 1H 2025, che prende in esame il primo semestre del 2025 e che mette in evidenza la diffusione di soluzioni AI sia tra le aziende sia tra i cyber criminali. L’effetto moltiplicatore dell’intelligenza artificiale, infatti, è osservabile sia nell’efficacia delle difese sia nella sofisticazione degli attacchi, ecco perché il 66% delle aziende interpellate si aspetta che entro l’anno proprio l’AI sarà il fattore più impattante sulla cybersecurity. Sempre per lo stesso motivo, da questo semestre la categoria dedicata all’AI è stata inserita all’interno di Pwn2Own.

Una parte rilevante del report è dedicata proprio all’analisi delle vulnerabilità individuate nella competizione Pwn2Own. In questo contesto, la prima falla documentata nella categoria AI riguarda il popolare database vettoriale open source Chroma DB, utilizzato per la Retrieval Augmented Generation. L’exploit, presentato dal team Summoning, ha dimostrato come dati e modelli operativi possano essere compromessi a causa di codice residuale rimanente dalle fasi di sviluppo. Le implicazioni sono notevoli, se si pensa che a maggio 2025 Trend Micro ha conteggiato oltre 200 server Chroma esposti senza autenticazione: una condizione che consente a un attaccante remoto l’accesso in lettura, scrittura e cancellazione dei dati.

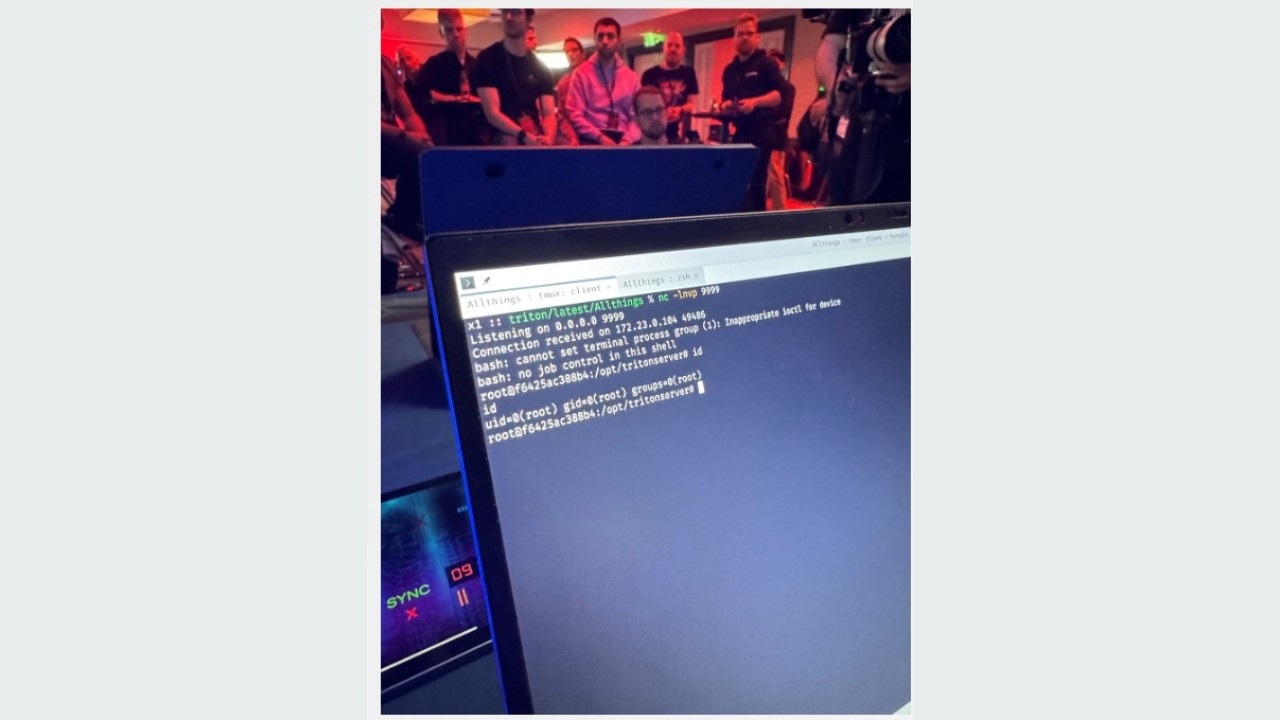

Un altro esempio riguarda l’attacco verso NVIDIA Triton Inference Server, che è un elemento cardine nelle infrastrutture AI orchestrate su Kubernetes. Qui a distinguersi è stata la capacità di concatenare quattro vulnerabilità note ma ancora prive di patch, che mette in risalto il problema annoso del patch management e nella mancanza di processi zero trust applicati alle architetture AI-native.

Lo sfruttamento di quattro bug concatenati per scatenare l’attacco contro NVIDIA Triton Inference server

Lo sfruttamento di quattro bug concatenati per scatenare l’attacco contro NVIDIA Triton Inference server

Il report prosegue fornendo dettagli sulle vulnerabilità identificate nei sistemi Redis, sempre più usati per la gestione di dati vettoriali nelle applicazioni AI. il caso è emblematico: un modulo Lua obsoleto, in cui era presente una combinazione di exploit e dipendenze non aggiornate, ha permesso di compromettere interi sistemi di caching, coinvolgendo oltre 2.000 istanze Redis 8 pubblicamente accessibili. Questo esempio mette l’accento sui problemi legati al massiccio uso di componenti terzi e librerie open source, spesso trascurate nei controlli di sicurezza.

Un altro esempio che dà la cifra dei problemi emergenti è quello emerso con un attacco di initialization of trusted variables nella gestione dell’NVIDIA Container Toolkit, che ha compromesso la sicurezza degli ambienti containerizzati. Di nuovo, per fronteggiare un rischio di questo tipo non sono sufficienti regole di perimeter security, occorrono un approccio zero trust e valutazioni continue di sicurezza applicativa.

LLM e affini

Sempre nella sezione vulnerabilità, viene dedicato ampio spazio al tema degli LLM agent e delle nuove forme di attacco legate alle interazioni multi-step e alla natura programmatica dei moderni agent intelligenti. A questo proposito Trend Micro presenta Pandora, un ambiente di test per AI agent costruito per simulare e documentare vettori d’attacco emergenti come l’indirect prompt injection. Questa tecnica consente a un attaccante di nascondere istruzioni malevole all’interno di contenuti apparentemente innocui (come link o testo invisibile), che poi vengono caricati dall’agente LLM e inseriti nei prompt, con l’effetto di far fuoriuscire dati sensibili o alterare i comportamenti dell’agente stesso.

Tra le minacce più rilevanti vi sono le cosiddette stored prompt injection e la manipolazione dei database vettoriali, in cui payload malevoli inseriti nei dati provocano effetti a cascata su generazione e accesso alle informazioni sensibili, anche quando sono presenti guardrail e filtri di sicurezza.

È inoltre interessante la parte relativa all’evoluzione degli attacchi mirati agli LLM – dalle semplici istruzioni “DAN” ormai superate fino alle più sofisticate tecniche di Prompt Leakage, che consentono l’estrazione dei prompt e il bypass dei filtri di sicurezza, sia su modelli open source sia proprietari. In questi casi le contromisure passano per l’impiego di output filtering, attività di red teaming e audit costanti.

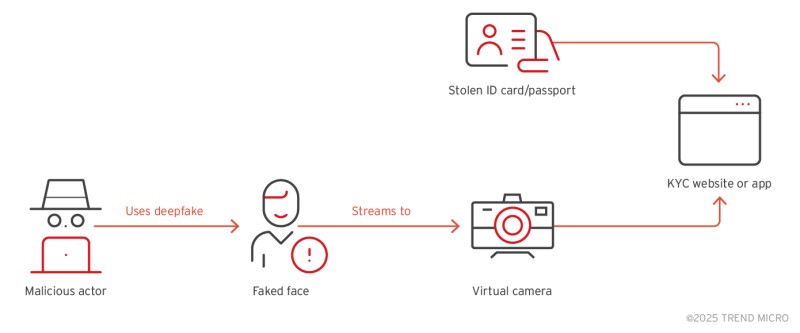

Il bypass di eKYC

Il bypass di eKYC

Vale la pena richiamare l’attenzione sul crescente interesse per i cosiddetti criminal GPT e dei servizi di jailbreak-as-a-service, in grado di aggirare le limitazioni etiche delle piattaforme generative tramite l’adozione delle più recenti tecniche di attacco ai prompt. Il fenomeno non è ancora particolarmente diffuso, ma aumenta la collaborazione tra gruppi underground.

Nell’ambito dei servizi criminali sta diventando infine rilevante il mercato di servizi bypass-as-a-service accessibili anche da attaccanti con competenze limitate, con costi che vanno dai 30 ai 600 dollari per singolo attacco. Si tratta di strumenti per la manipolazione vocale e video in tempo reale progettati per eludere i sistemi di verifica elettronica dell’identità (eKYC), soprattutto in ambito finanziario. A tale proposito, l’AI viene impiegata per generare deepfake capaci di bypassare i sistemi di verifica eKYC.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

Nasce una rete AI ombra: 175.000 server esposti online

30-01-2026

Quando l’intervento umano è preferibile: ripensare il ruolo dell’AI nell’assistenza clienti

30-01-2026

Acronis: dalla sicurezza preventiva alla cyber resilience nel disaster recovery

30-01-2026

Romance scam di San Valentino, quando l’amore diventa un rischio

29-01-2026

Redazione SecurityOpenLab

Redazione SecurityOpenLab