AGI oltre la fantascienza: realtà e rischi per le identità digitali del futuro

L’Artificial General Intelligence è lontana, ma la sua evoluzione impone già oggi nuove strategie di governance e sicurezza delle identità per aziende e operatori IT.

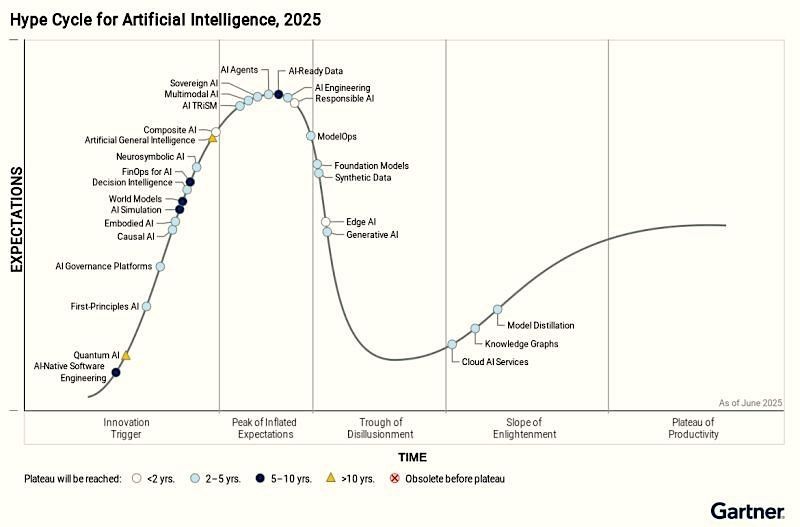

Secondo la celebre curva del Gartner Hype Cycle for Artificial Intelligence 2025, attualmente ci troviamo nella fase di disillusione della Generative AI; nel picco delle aspettative per gli Agent AI, l’AI-Ready Data, la Responsible AI, l’AI Engineering e l’AI multimodale. Mentre la Artificial General Intelligence fa capolino nella fase Innovation Trigger. Significa che, passata la fase di entusiasmo per la GenAI, adesso attenzione e investimenti sono focalizzati sulle applicazioni più specifiche, ma l’avanzamento tecnologico procede, tanto che già bolle in pentola l’AGI, una innovazione ancora in fase di ricerca e lontana dalla realtà operativa, per la quale Gartner fissa l’orizzonte di una ipotetica maturità di mercato almeno fra dieci anni.

Le tempistiche sembrano molto dilatate, ma secondo molti vale la pena iniziare a prendere confidenza con questo concetto. Fra questi c’è Massimo Carlotti, Sales Engineering Manager di CyberArk, che mette subito le cose in chiaro: “Oggi AGI non c’è: esistono solo teorie, posizioni contrastanti e una grande quantità di considerazioni su quando, se e come arriverà. C’è chi sostiene che si tratti solo di questione di tempo, chi è più critico e pensa che il circolo delle tecnologie attuali e delle economie necessarie rallenterà di fatto la marcia”.

Perché parlarne allora? Perché - spiega Carlotti - il solo fatto che se ne dibatta, anche in assenza di soluzioni operative, rivela un’esigenza di fondo attorno a cui già oggi si stanno costruendo riflessioni e strategie. “Vederci una necessità, un’esigenza reale o anche solo percepita, è già un elemento di riflessione: alcune scoperte avvengono inseguendo bisogni concreti, altre come tappe di un percorso o incidenti in un processo. Sta di fatto che, di fronte a una trasformazione così potenzialmente dirompente come quella promessa da AGI, conviene prepararsi fin da subito sul piano concettuale, tecnico e organizzativo”.

Massimo Carlotti, Sales Engineering Manager di CyberArk

Massimo Carlotti, Sales Engineering Manager di CyberArk

Detto questo, cerchiamo di capire di che cosa stiamo parlando. General Artificial Intelligence è una forma d'intelligenza artificiale che, qualora si realizzasse, avrebbe la funzione di supervisore degli AI agent. Semplificando al massimo, sarebbe un gestore dall’alto di una moltitudine di intelligenze artificiali specializzate e agentiche, attive su diversi livelli digitali e operativi.

Per Intelligenza Artificiale Generale (AGI) si intende un’intelligenza artificiale teorica che può comprendere, apprendere e applicare la conoscenza per risolvere problemi in modo versatile e autonomo, in qualsiasi contesto. A differenza dell’AI “stretta”, che eccelle solo in compiti specifici, l’AGI avrebbe la capacità di ragionare, pianificare e apprendere come un essere umano.

Il panorama odierno: identità e AI agentica

Dato che il concetto è complesso, facciamo un passo indietro a partiamo dal presente. Lo scenario attuale è dominato dagli agenti AI e dall’AI agentica: termini molto simili che però identificano oggetti differenti. Gli agenti AI sono tipicamente esecutori specialistici, con limitata o nessuna autonomia, che in genere svolgono compiti ben definiti e ripetibili. Il termine AI agentica si riferisce invece a sistemi o architetture che orchestrano più agenti, aggregando funzioni e contestualizzazione. Si avvicinano ad agenti capaci di prendere decisioni e di lavorare per obiettivi, seppur in ambiti circoscritti e specializzati.

In altre parole, l’AI agentica ha la funzione di supervisore degli AI agent: sarebbe un gestore dall’alto di una moltitudine di intelligenze artificiali specializzate e agentiche, attive su diversi livelli digitali e operativi.

“Nel contesto tecnico, tutte queste entità hanno un’identità. Per gli umani è un fatto intuitivo; per le macchine è più difficile da mettere a fuoco”, spiega Carlotti. Il manager fa riferimento in prima battuta alle identità macchina: a ogni applicazione o singola istanza operativa corrisponde una identità macchina distinta; secondo i dati citati da Carlotti, “nelle aziende, per ciascuna identità associata a una persona umana, ce ne sono mediamente tra 40 e 50 associate a entità non umane (machine identities). In alcuni casi, soprattutto nei contesti in cui proliferano agenti AI (che hanno identità proprie) e automazione, questo rapporto può salire fino a centinaia o addirittura decine di migliaia di identità macchina per ciascun utente umano”.

Questo da una parte si aggancia all’annoso problema di security della protezione delle identità: è imperativo riconoscere, gestire e monitorare in modo preciso ogni entità sia umana che non, perché ciascuna di esse dispone di credenziali, privilegi e ruoli propri. Dall’altra solleva un ulteriore problema: “i sistemi sono sempre più potenti, sempre più autonomi. Dagli agenti AI specializzati stiamo passando a orchestratori capaci di delegare, interpretare il contesto, prendere iniziative in ambiti sempre più ampi. Più gli agenti operano in autonomia, più il controllo sull’identità e sui permessi diventa fondamentale”.

Carlotti incalza: “Pensate al caso tipico delle aziende che, entusiaste di adottare il cloud, hanno concesso migliaia di permission puntuali durante le fasi di test, spesso senza sapere quali fossero effettivamente necessarie. Il risultato è uno scenario in cui non solo gli operatori umani, ma anche gli agenti e le automazioni possono agire con privilegi eccessivi, spesso senza controllo”. E chi ha letto qualche notizia di security ben conosce le conseguenze negative a cui portano la complessità e la scarsa visibilità sull’infrastruttura.

Il quadro si arricchisce aggiungendo un altro dettaglio rilevante, evidenziato da Carlotti: spesso le identità macchina, come quelle assegnate agli agenti AI o alle automazioni, dispongono di permessi più elevati rispetto a quelle umane. Questo perché, nella pratica aziendale, accade sovente che un agente sia configurato in maniera “più permissiva” dell’utente che lo ha generato, sia per comodità, sia per mancanza di chiarezza sui permessi realmente necessari, sia per dimenticanze durante le fasi di test o configurazione. Quando l’agente può agire con privilegi superiori a quelli dell’utente, significa che può accedere o manipolare dati e risorse che l’utente stesso non potrebbe controllare direttamente, amplificando così gli impatti potenziali di una falla o di un abuso.

Rispetto ai rischi, il salto non è solo quantitativo, come spiega Carlotti: “gli agenti AI introducono una nuova categoria nella cybersecurity. Sono macchine, ma si comportano come attori autonomi (e “quasi” umani): imparano, modificano account, fanno evolvere tattiche senza controllo umano puntuale”.

“La minaccia non è più solo esterna: se gli attaccanti dispongono di agenti AI, possono testare e aggirare le difese in modo adattivo e rapidissimo. Il cyberspazio si affolla di agenti che si spacciano per operatori, che scambiano mail, addirittura arricchite da contenuti voce (“vishing”) e video (“deepfake”)”. Davanti a questa minaccia occorrono meccanismi di riconoscimento e autenticazione radicalmente più robusti, basati anch’essi su agenti AI che attuano una supervisione dinamica.

La prospettiva dell’AGI

Addentrandoci nello scenario futuristico, è facile immaginare un momento in cui le AI specializzate saranno in numero e complessità tale da richiedere un livello gerarchico superiore. Per gestirle e orchestrarle con la dovuta efficienza sarà necessaria una capacità di calcolo elevatissima e un raggio di competenze altrettanto ampio: la risposta potrebbe essere la general intelligence, che può essere vista come una evoluzione spontanea che emerge da necessità concrete, o come un bisogno indotto per far crescere il business. Carlotti precisa che, allo stato attuale delle cose, “sono vere entrambe le istanze”.

Teorizzando che AGI possa fungere da supervisore universale a cui è affidato il compito di gestire e coordinare un’infrastruttura fluida, popolata da oggetti digitali via via più complessi e auto-coordinati, secondo Carlotti “il riconoscimento delle identità - sia digitali che naturali - rimarrà centrale. È una conseguenza diretta del fatto che ogni entità (umana o macchina) può compiere azioni nel sistema, spesso sulla base di permessi che, se configurati erroneamente, in assenza di un controllo rigoroso possono propagarsi nel sistema amplificando rischi e danni.

Restringendo il focus sulle identità, che è ambito di competenza di CyberArk, la gestione dei privilegi rappresenterà sempre di più il principale punto di controllo forte, perché permetterà di sapere chi sta facendo cosa e con quali privilegi, in modo da avere un punto di controllo centralizzato e circoscrivere incidenti, errori e abusi.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

La Certosa del Cloud

01-02-2026

Nasce una rete AI ombra: 175.000 server esposti online

30-01-2026

Quando l’intervento umano è preferibile: ripensare il ruolo dell’AI nell’assistenza clienti

30-01-2026

Acronis: dalla sicurezza preventiva alla cyber resilience nel disaster recovery

30-01-2026

Redazione SecurityOpenLab

Redazione SecurityOpenLab