Attacchi AI in tempo reale: evoluzione, tecniche e difesa

Un webinar di Acronis esplora l’evoluzione degli attacchi AI-driven, le nuove tecniche e le strategie di difesa più efficaci.

L’evoluzione degli attacchi cyber guidati dall’AI, la facilità di accesso a strumenti malevoli basati su LLM e deepfake, la crescente democratizzazione delle tecniche APT e la competizione tecnologica tra cybercrime e difesa sono stati i temi centrali affrontati da Gerald Beuchelt, CISO di Acronis, e Oleg Ishanov, Director della Threat Research Unit di Acronis, durante il recente webinar AI attacks LIVE: AI-powered attacks generated in real time and what you can do to stop them. L’incontro ha fornito una panoramica dettagliata sulle minacce emergenti, sulle tecniche di attacco che sfruttano AI e LLM, sulle strategie di elusione dei controlli tradizionali e sulle sfide che attendono il settore della cybersecurity.

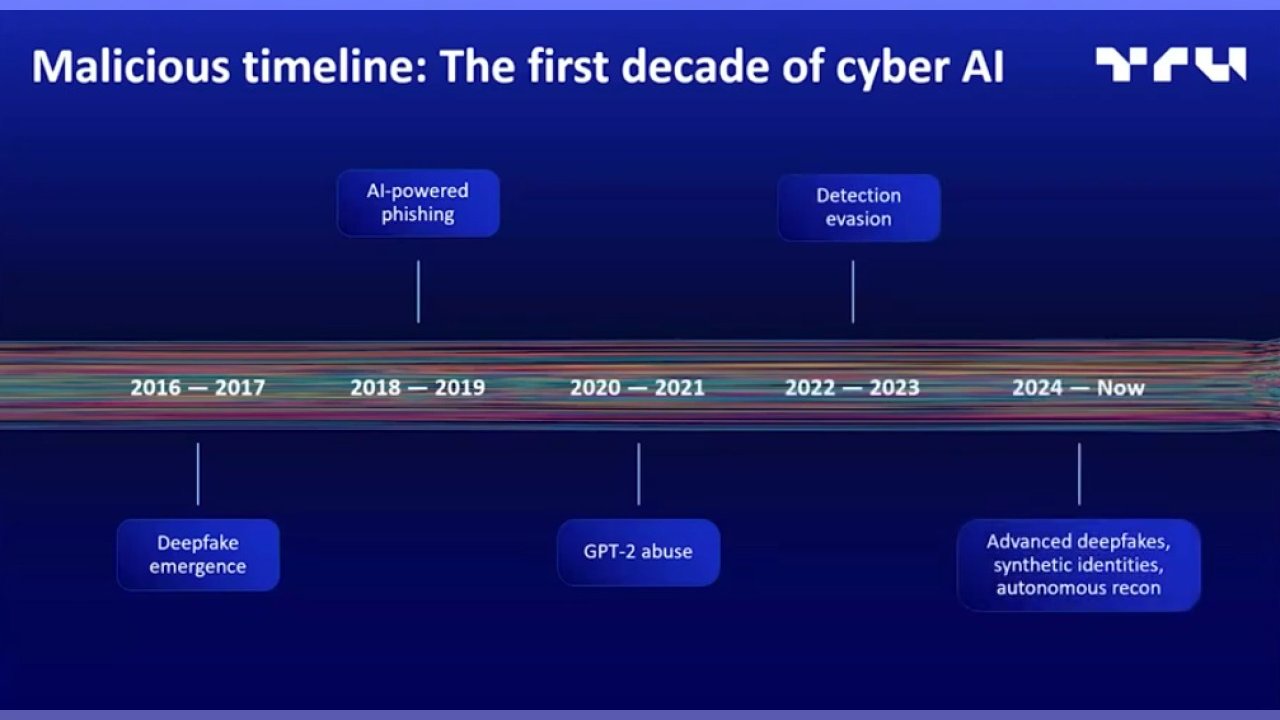

È spettato a Gerald Beuchelt ricostruire l’evoluzione dell’uso di strumenti AI, da parte del cybercrime, sottolineando come dai primi esperimenti di deepfake si sia passati a una diffusione capillare di strumenti malevoli accessibili a chiunque. Lo spartiacque è stato l’avvento dei modelli generativi, in particolare le prime versioni di GPT, che hanno abilitato la capacità di generare automaticamente contenuti quali phishing e malware su larga scala, abbattendo la barriera tecnica che separava i threat actor sofisticati dagli utenti comuni.

Dal 2022 in poi, la produzione di malware tramite AI è diventata una pratica alla portata di molti, con la possibilità di creare codice malevolo in pochi minuti, senza competenze avanzate di programmazione. Questo passaggio ha reso inefficaci molte soluzioni di detection basate su firme e, all’opposto, ha favorito la proliferazione di minacce personalizzate e difficili da intercettare.

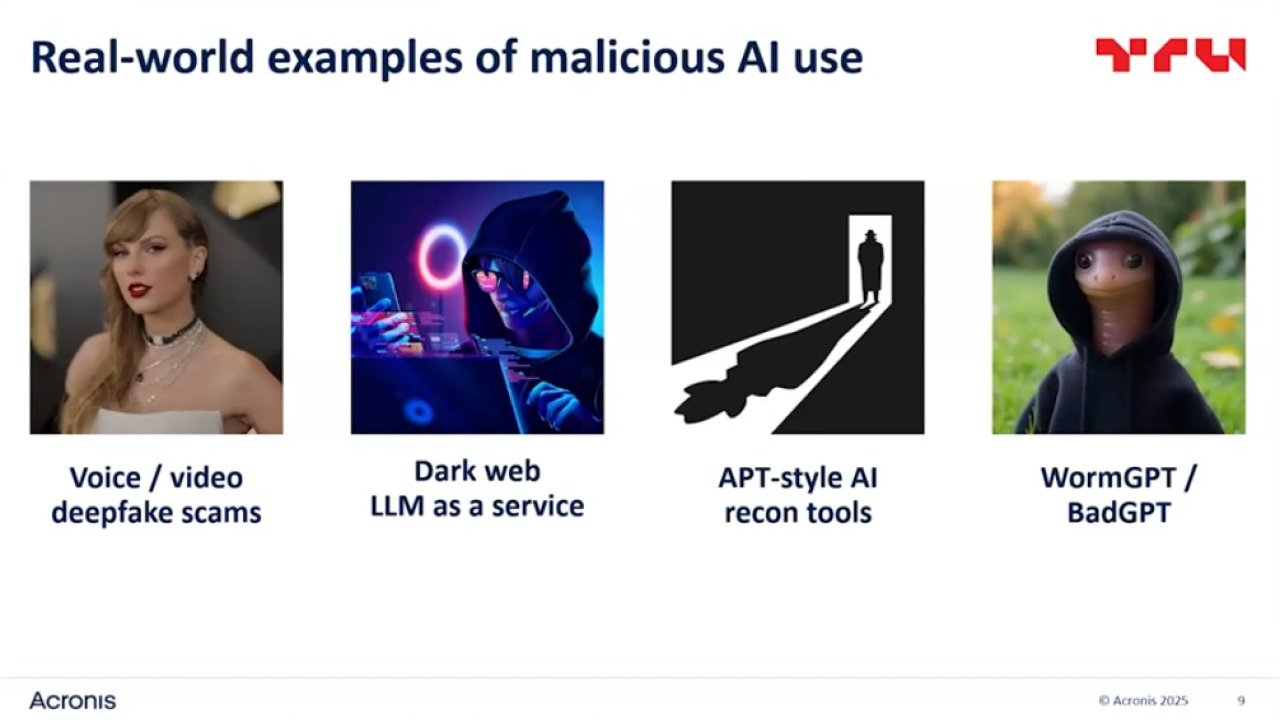

Fra le tecniche di raggiro più diffuse, il webinar ha evidenziato poi i deepfake, che hanno raggiunto livelli di realismo tali da rendere obsolete alcune forme di autenticazione. Oggi è possibile generare deepfake in tempo reale con hardware di fascia consumer e usare queste identità sintetiche credibili e difficili da smascherare per orchestrare attacchi mirati contro aziende e individui. Non solo. Sempre nell’ambito delle identità, gli agenti AI autonomi possono svolgere attività di ricognizione e interazione con altri sistemi tramite protocolli moderni come MCP, automatizzando la raccolta di informazioni sulle vittime.

Fra le tecniche di raggiro più diffuse, il webinar ha evidenziato poi i deepfake, che hanno raggiunto livelli di realismo tali da rendere obsolete alcune forme di autenticazione. Oggi è possibile generare deepfake in tempo reale con hardware di fascia consumer e usare queste identità sintetiche credibili e difficili da smascherare per orchestrare attacchi mirati contro aziende e individui. Non solo. Sempre nell’ambito delle identità, gli agenti AI autonomi possono svolgere attività di ricognizione e interazione con altri sistemi tramite protocolli moderni come MCP, automatizzando la raccolta di informazioni sulle vittime.

L’evoluzione del cybercrime

Beuchelt ha illustrato come il dark web abbia adottato un modello di divisione del lavoro, che ha portato all’offerta di servizi AI specializzati per ogni fase di un attacco cyber. Dalla generazione di malware alla creazione di campagne di phishing, passando per la manipolazione di contenuti multimediali e la gestione di bot di social media, esistono LLM come FraudGPT, WormGPT e altri, disponibili a prezzi accessibili e pagabili in criptovalute, che un tempo erano esclusiva di gruppi sponsorizzati da nazioni, sono ora alla portata di chiunque, anzi, abbattono ulteriormente la soglia di ingresso nel cybercrime.

L’apprendimento continuo dei modelli, alimentato dall’analisi di tool scoperti e condivisi nelle community underground, consente la generazione di payload sempre più efficaci e difficili da rilevare. Così facendo l’AI ha permesso di produrre varianti infinite di attacchi, adattando in tempo reale sia le tecniche che i contenuti sulla base delle difese incontrate. Lo scenario articolato e in continua evoluzione favorisce la personalizzazione estrema delle campagne malevole, con spear phishing e social engineering costruiti su misura per le vittime.

Come i vendor di cybersecurity sottolineano spesso, la scalabilità degli attacchi, unita alla velocità nella loro generazione, impone ai difensori di adottare strategie di detection e response altrettanto dinamiche, che si ottiene solo abbandonando l’approccio basato su regole statiche in favore di modelli comportamentali e di correlazione avanzata tra eventi.

Un tema centrale affrontato da Beuchelt e Ishanov riguarda la facilità con cui i controlli implementati dai vendor di LLM possono essere aggirati tramite tecniche di prompt engineering, che potremmo definire come l’arte di costruire richieste ambigue per ottenere output malevoli anche da modelli dotati di guardrail. SecurityOpenLab ha pubblicato molti articoli sul tema.

Demo e sfide aperte

Oleg Ishanov ha presentato una serie di demo live che avevano l’obiettivo di mostrare la concretezza e l’immediatezza delle minacce AI-driven. Strumenti come Stopwatch AI permettono di generare script dannosi per diverse piattaforme, scegliendo la tipologia di malware desiderata e personalizzando le funzionalità tramite prompt ottimizzati per eludere i controlli dei vendor. L’accessibilità di questi tool, spesso disponibili in modalità freemium, consente a chiunque di testare e perfezionare codice malevolo, con la possibilità di offuscazione automatica tramite modelli dedicati come Croc3 o Croc4. I test condotti su VirusTotal hanno dimostrato che la versione offuscata tramite AI riesce a eludere la quasi totalità dei motori di scansione basati su firme statiche.

La capacità delle AI di generare varianti uniche di codice malevolo rende poi inefficace il rilevamento basato su pattern statici. Ishanov ha sottolineato come la detection comportamentale, integrata da modelli AI dedicati all’analisi statica e dinamica, rappresenti oggi l’approccio più efficace per intercettare minacce evolute. Le soluzioni EDR e XDR, in grado di correlare eventi su più endpoint e di identificare anomalie comportamentali, sono fondamentali per contrastare attacchi che cambiano forma a ogni iterazione. La possibilità di integrare log e segnali da più fonti consente di costruire una visione olistica degli attacchi, superando i limiti delle soluzioni isolate.

Il fenomeno dei deepfake è stato analizzato sia dal punto di vista tecnico sia da quello operativo. Ishanov ha illustrato le fasi tecniche della produzione di un deepfake video, dalla rilevazione e allineamento del volto alla sovrapposizione della maschera digitale, fino all’integrazione dell’audio sintetico. La qualità raggiunta consente di orchestrare attacchi di business email compromise, frodi finanziarie e campagne di disinformazione con un realismo tale da ingannare anche interlocutori esperti. I casi citati includono truffe milionarie condotte tramite videoconferenze in cui i criminali impersonavano dirigenti aziendali e convincevano i destinatari a eseguire operazioni finanziarie sensibili.

Strategie di difesa

La difesa contro le minacce AI-driven richiede un approccio multilivello che integri tecnologia, formazione e procedure. Beuchelt ha evidenziato come la detection in tempo reale di deepfake audio e video sia ancora una sfida aperta, soprattutto in ambienti di collaborazione eterogenei come Zoom, Teams e WhatsApp. Sono in corso i primi tentativi di integrazione di tool di rilevamento direttamente nell’hardware, ma la protezione più efficace resta la formazione degli utenti e l’adozione di policy rigorose per la verifica delle informazioni sensibili. L’email security rappresenta tutt’oggi il fronte più avanzato per l’individuazione di contenuti generati artificialmente, mentre la detection di manipolazioni multimediali richiede ancora sviluppi significativi. Le soluzioni di backup e disaster recovery restano essenziali come ultima linea di difesa in caso di compromissione.

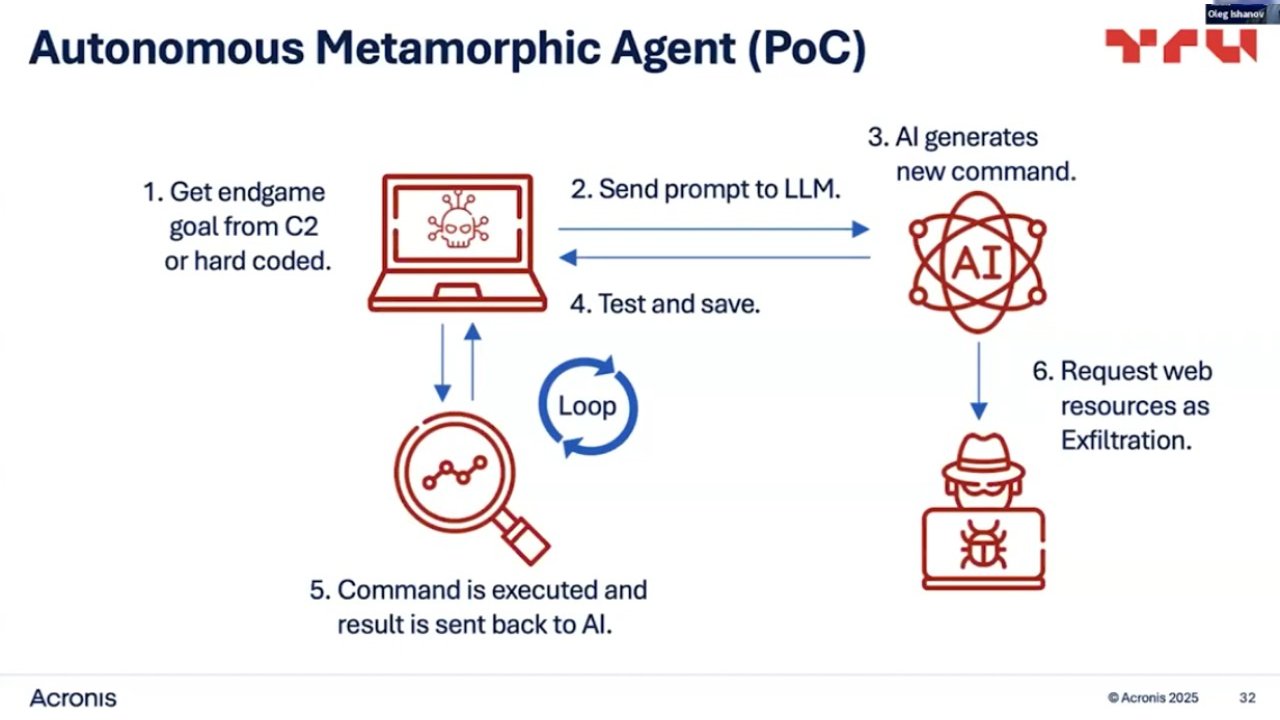

Infine, Ishanov ha delineato le prospettive future degli attacchi AI-driven, ipotizzando scenari in cui agenti malevoli autonomi saranno in grado di generare comandi unici per ogni vittima, rendendo impossibile il rilevamento tramite pattern ricorrenti. L’integrazione di feedback loop, in cui il malware apprende dai tentativi falliti e adatta le proprie tecniche di evasione, porterà a una nuova generazione di minacce metamorfiche, capaci di evolvere in tempo reale. L’uso combinato di AI per la generazione, l’offuscazione e la distribuzione di payload malevoli, unito alla capacità di orchestrare attacchi multi-canale, rappresenta la principale sfida per la cybersecurity nei prossimi anni.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

Cybercrime sempre più efficiente, Italia sotto pressione

27-02-2026

L’AI ridisegna la difesa, si va verso i SOC autonomi

26-02-2026

AI e vulnerabilità: come cambiano gli attacchi alle imprese

26-02-2026

Cyber Resilience: le lezioni di una crisi simulata /3

26-02-2026

Redazione SecurityOpenLab

Redazione SecurityOpenLab