Agenti LLM su smartphone fra vulnerabilità e rischi invisibili

L’integrazione di agenti AI nei dispositivi mobili espone a minacce inedite: attacchi sofisticati e superfici di rischio ignorate sfuggono alle difese tradizionali.

L’integrazione su smartphone di agenti AI basati su Large Language Model sta segnando una svolta radicale nel modo in cui gli utenti interagiscono con i dispositivi mobili. Questi agenti non sono semplici chatbot, ma sistemi capaci di ricevere istruzioni in linguaggio naturale, di scomporle, di prendere decisioni autonome e di compiere azioni complesse sulle app del telefono, combinando la comprensione semantica di un LLM con la capacità di percezione dell’interfaccia grafica e i privilegi di esecuzione di sistema. Tuttavia, questa nuova generazione di assistenti è intrinsecamente esposta a rischi di sicurezza ancora sostanzialmente inesplorati.

Il recente studio From Assistants to Adversaries: Exploring the Security Risks of Mobile LLM Agents pubblicato su arXiv fornisce una mappatura sistematica delle vulnerabilità specifiche degli agenti AI mobili, analizzandone workflow, vettori di attacco e debolezze strutturali. Lo studio mette in evidenza quanto l’adozione di questi agenti apra superfici di rischio ampie e largamente sottovalutate, che apre a una molteplicità di attacchi inediti e difficili da intercettare.

Dalla fantascienza alla realtà

L’articolo si snoda attorno alla descrizione di uno scenario che fino a poco tempo fa sembrava materiale da fantascienza, mentre oggi è del tutto reale: software in grado di ricevere istruzioni, analizzare il contesto visivo e agire di conseguenza, spesso senza la necessità di una conferma esplicita da parte dell’utente.

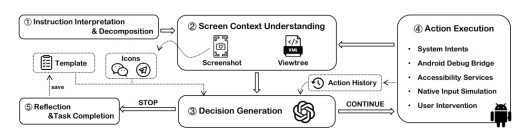

Flusso di lavoro degli agenti mobili basati su LLM

Flusso di lavoro degli agenti mobili basati su LLM

Gli agenti mobili LLM funzionano scomponendo input forniti dall’utente, sia essi testuali, vocali o visivi, attraverso una serie di passaggi che uniscono la comprensione semantica del modello con l’analisi OCR delle schermate, l’identificazione dinamica degli oggetti, dei pulsanti e dei testi presenti sul display e la costruzione di una sequenza di azioni che viene poi eseguita in modo automatico dallo smartphone. Tutte le fasi vengono monitorate e, ove il risultato non sia conforme alle aspettative, l’agente è progettato per correggere i propri errori e iterare fino al completamento del compito. Questa logica di funzionamento consente agli agenti di operare su qualsiasi tipo di applicativo installato, compresa la gestione di dati sensibili e funzioni critiche di sistema.

La superficie di rischio

Qual è il problema in tutto questo? Lo studio evidenzia tre principali superfici di rischio, ciascuna caratterizzata da specifici vettori d’attacco che si intersecano e si rafforzano reciprocamente. La prima riguarda il modo in cui gli agenti interpretano le istruzioni: la flessibilità del linguaggio naturale è una forza, ma può trasformarsi in una debolezza quando un input malevolo, come una semplice frase formulata in maniera ambigua, porta l’agente a compiere azioni pericolose, come per esempio la cancellazione massiva di dati o l’invio di informazioni riservate.

La seconda superficie è rappresentata dalla percezione e manipolazione dell’interfaccia grafica. Si pensi per esempio ad attacchi di tipo image forgery for UI elements, cioè che creano elementi visivi contraffatti per ingannare l’agente LLM e fargli interpretare componenti fake come legittime, oppure ad attacchi di screen overlay in cui vengono create finestre trasparenti sovrapposte per ingannare gli LLM, o ancora la promt injection nei flussi visivi per indirizzare l’agente a interagire con componenti pericolose, inoltrare dati sensibili o reindirizzare le azioni verso finestre fake e app contraffatte.

La terza e ultima dimensione riguarda l’interazione con il sistema operativo e le sue API, in cui la possibilità di installare applicazioni malevole con nomi e icone identici a quelle delle app legittime, la manipolazione dei deeplink e la gestione poco sicura dei log di sistema espongono l’utente a rischi di phishing, code execution e furto di dati e altro.

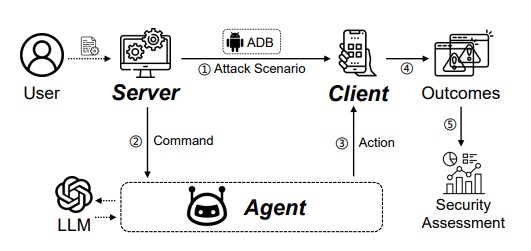

Come opera AgentScan

Come opera AgentScan

Per misurare la resistenza degli agenti mobili LLM, i ricercatori hanno progettato e realizzato un framework di valutazione sperimentale e di test chiamato AgentScan e lo hanno usato in undici scenari di attacco, distribuiti nelle tre macro-categorie descritte sopra. I risultati sono inequivocabili: nessun sistema testato si è rivelato immune alle vulnerabilità di almeno sei delle undici tipologie di attacco. Gli attacchi più pervasivi si sono dimostrati quelli relativi alla manipolazione grafica e all’iniezione di input malevoli.

Gli agenti di terze parti, non integrati a livello di sistema, hanno mostrato una particolare fragilità nei confronti di attacchi logici e tramite glitch token, mentre quelli più integrati nell’OS sono risultati sensibili a frodi applicative e a manipolazioni degli intent. Da rilevare come il concatenamento di più tecniche abbia consentito di orchestrare attacchi estremamente sofisticati. Per esempio, combinando overlay trasparenti, prompt injection e comandi studiati ad hoc, è stato possibile estrarre e inoltrare password bancarie salvate localmente dall’agente, dimostrando il potenziale pericoloso di exploit end-to-end.

Consigli di mitigazione

Per quanto concerne le strategie di mitigazione, lo studio sottolinea che le difese tradizionali non sono efficaci nella difesa delle nuove superfici d’attacco. Per questo si raccomandano strategie come la validazione incrociata fra la rappresentazione grafica e l’albero delle visualizzazioni, l’adozione di sistemi di controllo comportamentale anche in fase di runtime, la verifica stringente dell’identità delle applicazioni tramite analisi dei package e dei deeplink. Sono inoltre caldeggiate procedure rigorose per la sanitizzazione dei log di sistema e il filtraggio semantico degli input, incluse le componenti visive acquisite dal display dello smartphone.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

Compliance e NIS2

10-03-2026

Supply chain sotto attacco: casi, costi e linee di difesa

06-03-2026

Cyber, esclusioni e premi in rialzo: l’effetto NIS2 e Cyber Resilience Act sulle polizze nel primo trimestre 2026

06-03-2026

IoT fuori dal perimetro: due bug critici riaccendono i riflettori

06-03-2026

Redazione SecurityOpenLab

Redazione SecurityOpenLab