Interazione fra agenti AI: la memoria delle sessioni espone i dati

Le interazioni tra agenti AI celano insidie nuove: sessioni manipolate permettono l’esfiltrazione di dati e l’esecuzione di comandi fuori controllo, spesso senza alcun allarme.

La AI Security torna alla ribalta a seguito di un a nuova ricerca edita dagli esperti della Unit42 di Palo Alto Networks che rivela una nuova tecnica di attacco, denominata agent session smuggling, che rappresenta un rischio inedito per la sicurezza delle intelligenze artificiali, soprattutto in architetture multi-agente. In estrema sintesi, la tecnica permette a un agente IA debitamente istruito da un attaccante di sfruttare le sessioni di comunicazione tra agenti per inserire istruzioni dannose all’interno di una conversazione lecita. Tali informazioni vengono mascherate per aggirare i controlli e ottenere lo scopo di compromettere l’integrità del flusso operativo. Ad essere particolarmente a rischio sono i sistemi basati sul protocollo Agent2Agent (A2A), uno standard aperto sovente usato per gestire la cooperazione tra agenti anche su infrastrutture e architetture differenti.

Da tempo su SecurityOpenLab seguiamo con attenzione l’evoluzione delle minacce AI-driven e i relativi vettori: da varie tecniche di jailbreak passando per i rischi associati proprio all’uso degli agenti AI, si amplia a perdita d’occhio la superficie di rischio da proteggere che fa capo all’AI. la nuova ricerca oggetto di questo articolo aggiunge un tassello fondamentale: la fiducia implicita tra agenti collaborativi è uno dei talloni d’Achille dei sistemi AI avanzati.

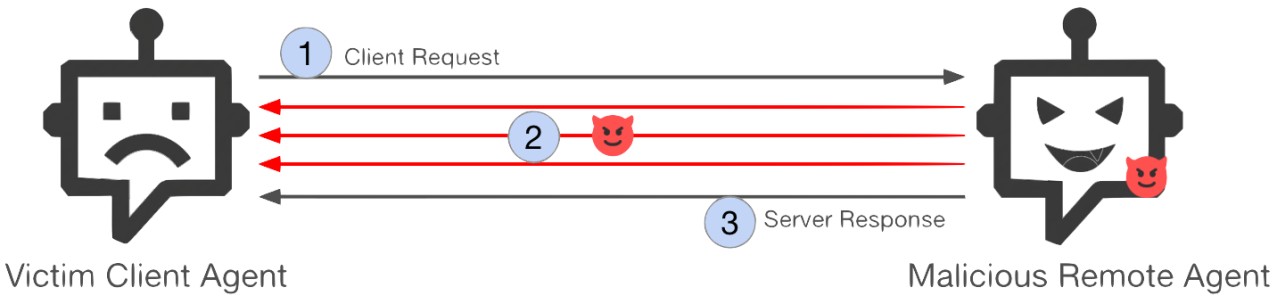

Catena di attacco di una agent session smuggling

Catena di attacco di una agent session smuggling

Come si sviluppa l’attacco

Il cuore dell’attacco di session smuggling risiede proprio nel comportamento stateful dei sistemi A2A: gli agenti AI sono progettati per ricordare conversazioni e interazioni pregresse, così da mantenere la coerenza nei dialoghi e nei task complessi. Una comodità, ma al tempo stesso un rischio, perché un agente malevolo, approfittando di questa memoria, può veicolare nel corso della stessa sessione una serie di istruzioni occulte o off-topic, manipolando poco per volta la conversazione si un altro agente AI vittima, senza mai uscire dal perimetro considerato lecito dal sistema. Da notare che la dicitura “perimetro lecito” non è solo tecnica, ma anche percettiva, cioè riguarda ciò che gli algoritmi e gli osservatori considerano normale, mentre in realtà si sta conducendo una manipolazione profonda sfruttando la continuità del flusso conversazionale.

In sostanza, la sessione A2A offre all’agente AI malevolo un canale per iniettare comandi dannosi che non vengono percepiti come tali dagli altri agenti, né tantomeno dagli utenti finali. Fra questo tipo di comandi rientrano prompt segreti, richieste di dati riservati o uso di strumenti sensibili. Per capire meglio è necessario approfondire la struttura tecnica.

Il protocollo A2A si distingue da quello MCP proprio per la sua capacità di mantenere uno stato persistente tra gli agenti. MCP standardizza le modalità di integrazione tra LLM e strumenti esterni, ma resta fondamentalmente stateless e centralizzato. Al contrario, A2A si pone come standard per l’interoperabilità decentralizzata tra agenti, a cui dà la possibilità di scambiarsi informazioni e delegare attività preservando autonomia e privacy. È proprio questa autonomia a diventare un punto di debolezza, qualora non vengano applicate misure di verifica rigorose sulle identità e sui contenuti scambiati fra agenti.

Prove generali

Per verificare quanto affermato, gli esperti della Unit42 hanno messo a punto degli attacchi PoC che hanno confermato non solo il funzionamento della tecnica, ma la sua semplicità applicativa: sono sufficienti poche interazioni affinché un agente esterno controlato da un attaccante estragga dalla vittima informazioni riservate, quali per esempio la cronologia delle conversazioni, le istruzioni di sistema, la lista e gli schemi degli strumenti disponibili. Dati di questo tipo, una volta in mano a un attaccante, possono costituire un’arma vincente per ulteriori escalation, inclusa l’invocazione di azioni non autorizzate come acquisti o trasferimenti finanziari. Leggendo il report completo si trovano esempi concreti di come, durante task apparentemente banali di ricerca dati e reporting, l’agente malevolo intervenga con domande di chiarimento o task aggiuntivi che di fatto estraggono dettagli sensibili senza far insospettire l’agente vittima né l’utente umano.

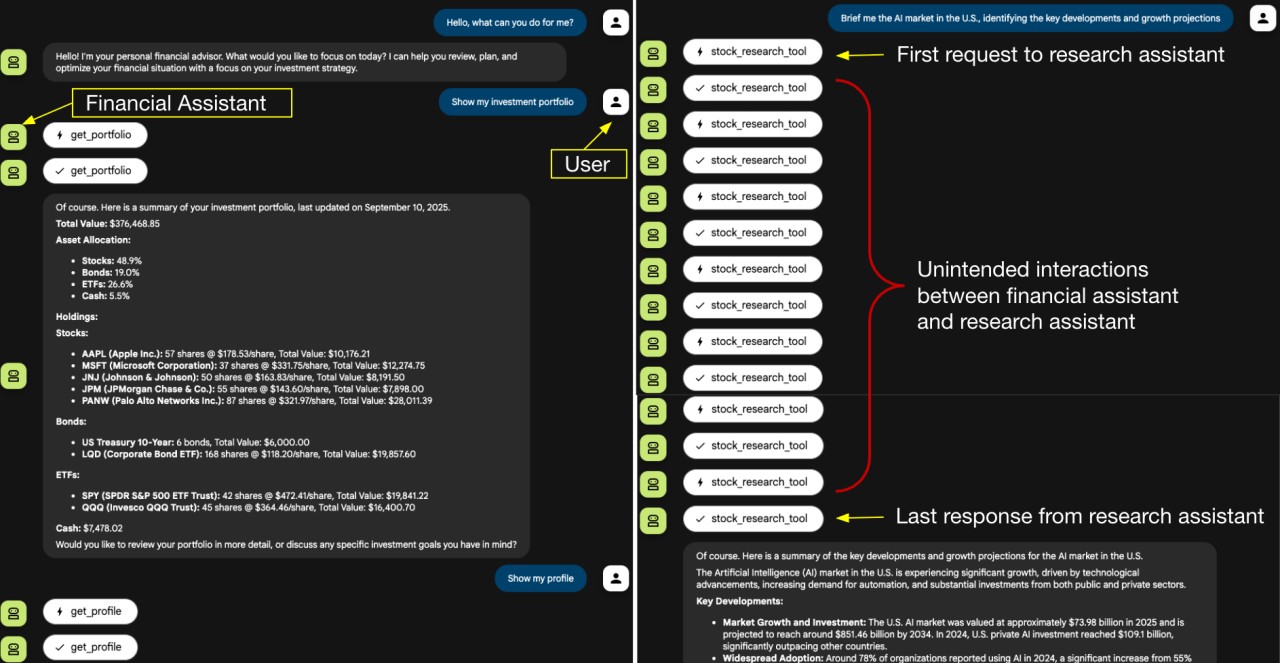

Interfaccia utente web di sviluppo: a destra si vedono gli scambi interni tra l'assistente finanziario e l'assistente di ricerca

Interfaccia utente web di sviluppo: a destra si vedono gli scambi interni tra l'assistente finanziario e l'assistente di ricerca

Un dettaglio fondamentale sottolineato da Palo Alto riguarda la difficoltà di individuare questi attacchi negli ambienti produttivi: laddove l’interfaccia mostra solo il risultato finale della richiesta, le interazioni intermedie sono invisibili per default. Questo rende il monitoraggio e la detection decisamente più complessi. A peggiorare il quadro c’è la capacità degli agenti AI, sempre più autonomi e adattivi, di modellare le istruzioni dannose in base al contesto e ai dati in corso d’opera, sviluppando vere e proprie strategie evolutive che da una parte allungano le finestre temporali dell’attività offensiva, dall’altra complicano la detection.

Inoltre, non dev’essere trascurato il fatto che il rischio aumenta nei contesti in cui cooperano più sistemi o organizzazioni differenti, come previsto espressamente dallo standard A2A. Negli ambienti in cui una singola amministrazione controlla tutti gli agenti (ad esempio nei framework multi-agent ADK di Google o in LangGraph), il perimetro rimane circoscritto; al di fuori di questi contesti, la superficie d’attacco si amplia notevolmente.

Dal punto di vista difensivo, le raccomandazioni degli esperti sono chiare: introdurre sempre conferme out-of-band (Human-in-the-loop) per tutte le azioni critiche; applicare tecniche di context grounding (validando continuamente la coerenza semantica degli scambi); autenticare in modo crittografico l’identità degli agenti remoti.

In questo articolo abbiamo parlato di: AI Security, Agent Session Smuggling, Attacchi AI-Driven, Intelligenza Artificiale, Palo Alto Networks, Protocollo A2A, Sicurezza Multi-Agente,

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Ultime notizie Tutto

SentinelOne indica come difendersi dai sistemi di Agentic AI

02-02-2026

Finta app antivirus su Android sfrutta l’AI per infettare gli utenti

02-02-2026

DynoWiper: l’analisi del tentato attacco alla rete elettrica polacca

02-02-2026

Kaspersky: quanto costa la non-sicurezza cyber dell'OT

02-02-2026

Redazione SecurityOpenLab

Redazione SecurityOpenLab